WikiDer > Остаточная нейронная сеть

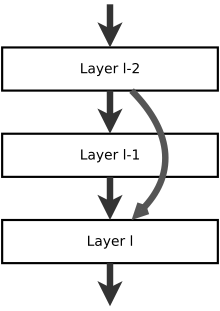

А остаточная нейронная сеть (ResNet) является искусственная нейронная сеть (ИНС) типа, который основан на конструкциях, известных из пирамидные клетки в кора головного мозга. Остаточные нейронные сети делают это, используя пропустить соединения, или же ярлыки перепрыгнуть через несколько слоев. Типичный ResNet модели реализуются с двух- или трехслойными пропусками, которые содержат нелинейности (ReLU) и пакетная нормализация между.[1][2] Дополнительная матрица весов может использоваться для определения весов пропусков; эти модели известны как HighwayNets.[3] Модели с несколькими параллельными пропусками называются DenseNets.[4][5] В контексте остаточных нейронных сетей неостаточная сеть может быть описана как простая сеть.

Одна из мотиваций для пропуска слоев - избежать проблемы исчезающие градиенты, повторно используя активации из предыдущего слоя, пока соседний слой не узнает свои веса. Во время тренировки веса адаптируются для отключения звука вышестоящего слоя.[требуется разъяснение], и усилить ранее пропущенный слой. В простейшем случае адаптируются только веса для соединения соседнего уровня, без явных весов для восходящего уровня. Это лучше всего работает, когда переступает один нелинейный слой или когда все промежуточные слои являются линейными. Если нет, то следует изучить явную матрицу весов для пропущенного соединения ( HighwayNet должен быть использован).

Пропуск эффективно упрощает сеть, используя меньшее количество слоев на начальных этапах обучения.[требуется разъяснение]. Это ускоряет обучение за счет уменьшения влияния исчезающих градиентов, так как меньше слоев для распространения. Затем сеть постепенно восстанавливает пропущенные слои по мере изучения пространство функций. Ближе к концу обучения, когда все слои развернуты, он остается ближе к коллектору.[требуется разъяснение] и таким образом учится быстрее. Нейронная сеть без остаточных частей исследует больше пространства функций. Это делает его более уязвимым для возмущений, которые заставляют его покидать коллектор, и требует дополнительных обучающих данных для восстановления.

Биологический аналог

Мозг имеет структуры, похожие на остаточные сети, так как нейроны VI коркового слоя получить входные данные со слоя I, пропуская промежуточные слои.[6] На рисунке это сравнивается с сигналами от апикального дендрита (3), пропускающего слои, в то время как базальный дендрит (2) собирает сигналы от предыдущего и / или того же слоя.[примечание 1][7] Подобные структуры существуют и для других слоев.[8] Неясно, сколько слоев коры головного мозга можно сравнить со слоями искусственной нейронной сети, и каждая ли область в нейронной сети кора головного мозга имеет ту же структуру, но на больших площадях они кажутся похожими.

Прямое распространение

Для одиночных пропусков слои могут быть проиндексированы как к или как к . (Скрипт используется для ясности, обычно пишется как простой л.) Две системы индексации удобны при описании пропусков как движущихся вперед или назад. По мере прохождения сигнала по сети этот пропуск легче описать как из данного слоя, но в качестве правила обучения (обратное распространение) легче описать, какой слой активации вы повторно используете как , куда это номер пропуска.

Учитывая весовую матрицу для соединительных грузов из слоя к , и матрица весов для соединительных грузов из слоя к , то прямое распространение через функцию активации будет (иначе HighwayNets)

куда

- активации (выходы) нейронов в слое ,

- функция активации для слоя ,

- матрица весов для нейронов между слоями и , и

Отсутствие явной матрицы (он же ResNets) прямое распространение через функцию активации упрощается до

Другой способ сформулировать это - заменить единичную матрицу , но это действительно только при совпадении размеров. Это несколько сбивает с толку блок идентификации, что означает, что активации из слоя передаются на слой без утяжеления.

В коре больших полушарий такие перескоки делаются для нескольких слоев. Обычно все переходы вперед начинаются с одного и того же слоя и последовательно соединяются с более поздними уровнями. В общем случае это будет выражаться как (иначе DenseNets)

- .

Обратное распространение

В течение обратное распространение обучение нормальному пути

и для путей пропуска (почти идентичны)

- .

В обоих случаях

- а скорость обучения (,

- сигнал ошибки нейронов на слое , и

- активация нейронов в слое .

Если путь пропуска имеет фиксированные веса (например, единичная матрица, как указано выше), то они не обновляются. Если они могут быть обновлены, это правило является обычным правилом обновления с обратным распространением.

В общем случае может быть пропустить матрицы весов, таким образом

Поскольку правила обучения схожи, весовые матрицы можно объединить и изучить на одном шаге.

Примечания

- ^ Некоторые исследования показывают, что здесь есть дополнительные структуры, поэтому это объяснение несколько упрощено.

Рекомендации

- ^ Он, Кайминг; Чжан, Сянъюй; Рен, Шаоцин; Сунь, Цзянь (10 декабря 2015 г.). «Глубокое остаточное обучение для распознавания изображений». arXiv:1512.03385 [cs.CV].

- ^ Он, Кайминг; Чжан, Сянъюй; Рен, Шаоцин; Сунь, Цзянь (2016). «Глубокое остаточное обучение для распознавания изображений» (PDF). Proc. Компьютерное зрение и распознавание образов (CVPR), IEEE. Получено 2020-04-23.

- ^ Шривастава, Рупеш Кумар; Грефф, Клаус; Шмидхубер, Юрген (2 мая 2015 г.). «Автомобильные сети». arXiv:1505.00387 [cs.LG].

- ^ Хуанг, Гао; Лю, Чжуан; Weinberger, Kilian Q .; ван дер Маатен, Лоренс (2016-08-24). «Плотно связанные сверточные сети». arXiv:1608.06993 [cs.CV].

- ^ Хуанг, Гао; Лю, Чжуан; Weinberger, Kilian Q .; ван дер Маатен, Лоренс (2017). «Плотно связанные сверточные сети» (PDF). Proc. Компьютерное зрение и распознавание образов (CVPR), IEEE. Получено 2020-04-23.

- ^ Томсон, AM (2010). «Неокортикальный слой 6, обзор». Границы нейроанатомии. 4: 13. Дои:10.3389 / fnana.2010.00013. ЧВК 2885865. PMID 20556241.

- ^ Зимовщик, Йохен; Майер, Николаус; Возны, Кристиан; Beed, Prateep; Бреустедт, Йорг; Евангелиста, Роберта; Пэн, Янфань; Д’Альбис, Тициано; Кемптер, Ричард (2017). «Возбуждающие микросхемы в поверхностных слоях медиальной энторинальной коры». Отчеты по ячейкам. 19 (6): 1110–1116. Дои:10.1016 / j.celrep.2017.04.041. PMID 28494861.

- ^ Фитцпатрик, Дэвид (1996-05-01). "Функциональная организация локальных цепей в зрительной коре головного мозга: выводы из исследования полосатой коры древовидной землероки". Кора головного мозга. 6 (3): 329–341. Дои:10.1093 / cercor / 6.3.329. ISSN 1047-3211. PMID 8670661.