WikiDer > Ceph (программное обеспечение)

Эта статья слишком полагается на Рекомендации к основные источники. (Март 2018 г.) (Узнайте, как и когда удалить этот шаблон сообщения) |

| |

| Оригинальный автор (ы) | Инктанк Хранилище (Мудрец Вейль, Иегуда Садех Вайнрауб, Грегори Фарнум, Джош Дургин, Самуэль Джаст, Видо ден Холландер) |

|---|---|

| Разработчики) | Канонический, ЦЕРН, Cisco, Fujitsu, Intel, Красная шляпа, SanDisk, и SUSE[1] |

| Стабильный выпуск | 15.2.5 «Осьминог»[2] / 16 сентября 2020 |

| Репозиторий | |

| Написано в | C ++, Python[3] |

| Операционная система | Linux, FreeBSD[4] |

| Тип | Распределенное хранилище объектов |

| Лицензия | LGPLv2.1[5] |

| Интернет сайт | цеф |

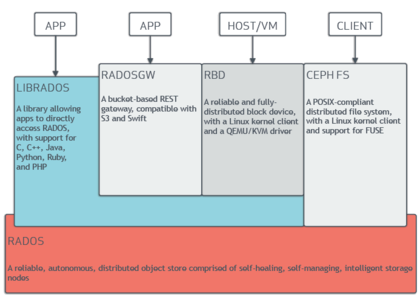

Ceph (произносится /ˈsɛж/) является программное обеспечение с открытым исходным кодом место хранения Платформа, реализует объектное хранилище на одном распределенном компьютерный кластер, и предоставляет интерфейсы 3in1 для: object-, блокировать- и файловый уровень место хранения. Ceph в первую очередь ориентирован на полностью распределенную работу без единая точка отказа, масштабируемый до эксабайт уровне и в свободном доступе.

Ceph копирует данные и делает это отказоустойчивой,[6] с помощью товарное оборудование и не требует специальной аппаратной поддержки. Благодаря своей конструкции система является как самовосстанавливающейся, так и самоуправляемый, чтобы минимизировать время администрирования и другие расходы.

Дизайн

Ceph использует пять различных типов демоны:[7]

- Кластерные мониторы (цеф-мон), которые отслеживают активные и неисправные узлы кластера, конфигурацию кластера и информацию о размещении данных и глобальном состоянии кластера.

- Устройства хранения объектов (ceph-osd), которые используют прямое журналируемое дисковое хранилище (с именем BlueStore,[8] который с выпуска v12.x заменяет FileStore[9] который будет использовать файловую систему)

- Метаданные серверы (ceph-mds), что кеш и брокерский доступ к inodes и каталоги внутри файловой системы CephFS.

- HTTP шлюзы (ceph-rgw), которые предоставляют уровень хранения объектов как интерфейс, совместимый с Amazon S3 или же OpenStack Swift API

- Менеджеры (ceph-mgr), которые выполняют задачи мониторинга, учета и обслуживания кластера, а также взаимодействуют с внешними системами мониторинга и управления (например, балансировщиком, приборной панелью, Прометей, Плагин Zabbix)[10]

Все они полностью распределены и могут работать на одном наборе серверов. Клиенты с разными потребностями могут напрямую взаимодействовать с разными подмножествами.[11]

Ceph делает чередование отдельных файлов на нескольких узлах для достижения более высокой пропускной способности, аналогично тому, как RAID0 полосы разделяют несколько жесткие диски. Адаптивный Балансировка нагрузки поддерживается, при этом часто используемые объекты реплицируются на большее количество узлов.[нужна цитата] По состоянию на сентябрь 2017 г.[Обновить], BlueStore - это стандартный и рекомендуемый тип хранилища для производственных сред,[12] это собственная реализация хранилища Ceph, обеспечивающая лучшую задержку и настраиваемость, чем серверная часть файлового хранилища, и позволяющая избежать недостатков хранилища на основе файловой системы, включая дополнительные уровни обработки и кэширования. Бэкэнд Filestore по-прежнему считается полезным и очень стабильным; XFS использовался как рекомендуемый базовый тип файловой системы для производственных сред, в то время как Btrfs был рекомендован для непроизводственной среды. ext4 использование файловых систем не рекомендуется из-за ограничений на максимальную длину объектов RADOS.[13] Даже при использовании BlueStore XFS используется для небольшого раздела метаданных.[14]

Хранилище объектов

Ceph реализует распределенные объектное хранилище - BlueStore. Программные библиотеки Ceph предоставляют клиентским приложениям прямой доступ к надежное автономное распределенное хранилище объектов (RADOS) объектно-ориентированная система хранения, а также обеспечивает основу для некоторых функций Ceph, включая Блочное устройство RADOS (RBD), RADOS шлюз, а Файловая система Ceph.

"Либрадо" программные библиотеки предоставить доступ в C, C ++, Ява, PHP, и Python. Шлюз RADOS также предоставляет хранилище объектов как RESTful интерфейс, который может быть как родным Amazon S3 и OpenStack Swift API.

Блочное хранилище

Система хранения объектов Ceph позволяет пользователям монтировать Ceph как с тонким предоставлением блочное устройство. Когда приложение записывает данные в Ceph с помощью блочного устройства, Ceph автоматически распределяет и реплицирует данные в кластере. Ceph's Блочное устройство RADOS (RBD) также интегрируется с Виртуальные машины на основе ядра (КВМ).

Ceph RBD взаимодействует с той же системой хранения объектов Ceph, которая предоставляет интерфейс librados и файловую систему CephFS, и хранит образы блочных устройств как объекты. Поскольку RBD построен на librados, RBD наследует возможности librados, включая моментальные снимки только для чтения и возврат к моментальным снимкам. Распределяя образы по кластеру, Ceph улучшает производительность доступа на чтение для образов больших блочных устройств.

Блочное устройство можно виртуализировать, предоставляя блочное хранилище виртуальным машинам на платформах виртуализации, таких как Apache CloudStack, OpenStack, OpenNebula, Ганети, и Виртуальная среда Proxmox.

Файловая система

Файловая система Ceph (CephFS) работает поверх той же системы хранения объектов, которая обеспечивает хранилище объектов и интерфейсы блочных устройств. Кластер серверов метаданных Ceph предоставляет службу, которая сопоставляет каталоги и имена файлов файловой системы с объектами, хранящимися в кластерах RADOS. Кластер сервера метаданных может расширяться или сжиматься, и он может динамически перебалансировать файловую систему для равномерного распределения данных между узлами кластера. Это обеспечивает высокую производительность и предотвращает большие нагрузки на определенные хосты в кластере.

Клиенты монтируют POSIX-совместимая файловая система с использованием Ядро Linux клиент. Более старый ПРЕДОХРАНИТЕЛЬ-базовый клиент также доступен. Серверы работают как обычные Unix демоны.

История

Ceph был первоначально создан Мудрец Вейль за его докторская диссертация,[15] которую посоветовал профессор Скотт А. Брандт из Jack Баскин инженерная школа, Калифорнийский университет в Санта-Крус (UCSC) и спонсируется Расширенная программа моделирования и вычислений (ASC), включая Лос-Аламосская национальная лаборатория (LANL), Сандийские национальные лаборатории (SNL) и Национальная лаборатория Лоуренса Ливермора (LLNL).[16] Первая строка кода, которая в итоге стала частью Ceph, была написана Sage Weil в 2004 году во время летней стажировки в LLNL, работая над масштабируемым управлением метаданными файловой системы (известным сегодня как MDS Ceph).[17] В 2005 году в рамках летнего проекта, инициированного Скоттом А. Брандтом и возглавляемого Карлосом Мальтзаном, Сейдж Вейл создал полнофункциональный прототип файловой системы, получивший название Ceph. Ceph дебютировал с Sage Weil, который провел две презентации в ноябре 2006 года, одну на USENIX OSDI 2006[18] и еще один в SC'06.[19]

После его выпуска осенью 2007 года Вайль продолжил работать над Ceph на постоянной основе, а основная группа разработчиков расширилась за счет Иегуды Сада Вайнрауба и Грегори Фарнума. 19 марта 2010 г. Линус Торвальдс объединил клиент Ceph с ядром Linux версии 2.6.34[20][21] который был выпущен 16 мая 2010 года. В 2012 году Вейл создал Инктанк Хранилище за профессиональные услуги и поддержку Ceph.[22][23]

В апреле 2014 г. Красная шляпа приобрела Inktank, взяв на себя большую часть разработок Ceph.[24]

В октябре 2015 года был сформирован Консультативный совет сообщества Ceph, чтобы помочь сообществу в продвижении вперед технологии программно-определяемых хранилищ с открытым исходным кодом. В консультативный совет по уставу входят члены сообщества Ceph из глобальных ИТ-организаций, приверженных проекту Ceph, включая лиц из Канонический, ЦЕРН, Cisco, Fujitsu, Intel, Красная шляпа, SanDisk, и SUSE.[25]

История выпуска

| Имя | Релиз | Первый выпуск | Конец чего-либо жизнь | Вехи |

|---|---|---|---|---|

| Аргонавт | 0.48 | 3 июля 2012 г. | Первый крупный «стабильный» выпуск | |

| Бобтейл | 0.56 | 1 января 2013 г. | ||

| Каракатица | 0.61 | 7 мая 2013 г. | ceph-deploy стабилен | |

| Клецки | 0.67 | 14 августа 2013 г. | Май 2015 г. | пространство имен, регион, мониторинг REST API |

| Император | 0.72 | 9 ноября 2013 г. | Май 2014 г. | репликация из нескольких центров обработки данных для Radosgw |

| Светлячок | 0.80 | 7 мая 2014 г. | Апрель 2016 г. | кодирование со стиранием, многоуровневое кеширование, первичная привязка, бэкэнд OSD ключ / значение (экспериментальный), автономный radosgw (экспериментальный) |

| Гигант | 0.87 | 29 октября 2014 г. | Апрель 2015 г. | |

| Молоток | 0.94 | 7 апреля 2015 г. | Август 2017 г. | |

| Инферналис | 9.2.0 | 6 ноября 2015 г. | Апрель 2016 г. | |

| Драгоценность | 10.2.0 | 21 апреля 2016 г. | 2018-06-01 | Стабильная CephFS, экспериментальная серверная часть RADOS под названием BlueStore |

| Kraken | 11.2.0 | 20 января 2017 г. | 2017-08-01 | BlueStore работает стабильно |

| Светящийся | 12.2.0 | 29 августа 2017 г. | ||

| Мимика | 13.2.0 | 1 июня 2018 г. | снимки стабильны, Зверь стабильный | |

| Наутилус | 14.2.0 | 19 марта 2019 г., | ||

| Осьминог | 15.2.0 | 23 марта 2020 г. | ||

| Тихий океан | 16.0.0 |

Этимология

Название «Цеф» является сокращением от «головоногие моллюски", класс моллюски это включает осьминога. Название (подчеркнутое логотипом) предполагает очень параллельное поведение осьминога и было выбрано для связи файловой системы с «Сэмми», банановый слизень талисман UCSC.[7] И головоногие, и банановые слизни - это моллюски.

Смотрите также

- BeeGFS

- Распределенная файловая система

- Распределенные параллельные отказоустойчивые файловые системы

- Файловая система Gfarm

- GlusterFS

- Общая параллельная файловая система IBM (GPFS)

- Ящерица

- Блеск

- MapR FS

- Файловая система Moose

- OrangeFS

- Параллельная виртуальная файловая система

- Файловая система Quantcast

- RozoFS

- XtreemFS

- ZFS

- Сравнение распределенных файловых систем

Рекомендации

- ^ "Консультативный совет по формам сообщества Ceph". 2015-10-28. Архивировано из оригинал на 2019-01-29. Получено 2016-01-20.

- ^ "Выпущен Octopus v15.2.5".

- ^ "Репозиторий GitHub".

- ^ «Ежеквартальный отчет о состоянии FreeBSD».

- ^ "Файл лицензии LGPL2.1 в исходниках Ceph". 2014-10-24. Получено 2014-10-24.

- ^ Джереми Эндрюс (2007-11-15). "Распределенная сетевая файловая система Ceph". KernelTrap. Архивировано из оригинал на 2007-11-17. Получено 2007-11-15.

- ^ а б c М. Тим Джонс (04.06.2010). "Ceph: распределенная файловая система Linux петабайтного масштаба" (PDF). IBM. Получено 2014-12-03.

- ^ «BlueStore». Ceph. Получено 2017-09-29.

- ^ «Миграция в BlueStore». Получено 2020-04-12.

- ^ "Демон менеджера Ceph - Документация Ceph". docs.ceph.com. Получено 2019-01-31.

- ^ Джейк Эдж (14 ноября 2007 г.). "Файловая система Ceph". LWN.net.

- ^ Мудрец Вейл (2017-08-29). "Версия 12.2.0 Luminous выпущена". Блог Ceph.

- ^ «Рекомендации по жесткому диску и файловой системе». ceph.com. Архивировано из оригинал на 2017-07-14. Получено 2017-06-26.

- ^ «Справочник по конфигурации BlueStore». Получено 12 апреля, 2020.

- ^ Мудрец Вейл (2007-12-01). «Ceph: надежное, масштабируемое и высокопроизводительное распределенное хранилище» (PDF). Калифорнийский университет в Санта-Крус.

- ^ Гэри Грайдер (2004-05-01). "История и стратегия масштабируемого ввода-вывода ASCI / DOD" (PDF). Университет Миннесоты. Получено 2019-07-17.

- ^ Управление динамическими метаданными для файловых систем петабайтного масштаба, С. А. Вейл, К. Т. Поллак, С. А. Брандт, Э. Л. Миллер, Proc. SC'04, Питтсбург, Пенсильвания, ноябрь 2004 г.

- ^ «Ceph: масштабируемая высокопроизводительная распределенная файловая система», С. А. Вейл, С. А. Брандт, Э. Л. Миллер, DDE Long, С. Мальцан, Proc. OSDI, Сиэтл, Вашингтон, ноябрь 2006 г.

- ^ «CRUSH: контролируемое, масштабируемое, децентрализованное размещение реплицированных данных», С. А. Вейл, С. А. Брандт, Э. Л. Миллер, DDE Long, С. Мальцан, SC'06, Тампа, Флорида, ноябрь 2006 г.

- ^ Мудрец Вейл (19 февраля 2010 г.). "Клиент объединен для 2.6.34". ceph.newdream.net.

- ^ Тим Стивенс (2010-05-20). «Новая версия ОС Linux включает файловую систему Ceph, разработанную в UCSC». news.ucsc.edu.

- ^ Брайан Богенсбергер (03.05.2012). "И все это вместе". Блог Инктанк. Архивировано из оригинал в 2012-07-19. Получено 2012-07-10.

- ^ Джозеф Ф. Ковар (10 июля 2012 г.). «10 самых крутых стартапов 2012 года (пока что)». CRN. Получено 19 июля, 2013.

- ^ Red Hat Inc (30 апреля 2014 г.). «Red Hat приобретает Inktank, поставщика Ceph». Красная шляпа. Получено 2014-08-19.

- ^ "Консультативный совет по формам сообщества Ceph". 2015-10-28. Архивировано из оригинал на 2019-01-29. Получено 2016-01-20.

дальнейшее чтение

- М. Тим Джонс (2010-05-04). "Ceph: распределенная файловая система Linux петабайтного масштаба". developerWorks> Linux> Техническая библиотека. Получено 2010-05-06.

- Джеффри Б. Лейтон (2010-04-20). "Ceph: Существо распределенной файловой системы из лагуны объектов". Журнал Linux. Получено 2010-04-24.

- Карлос Мальцан; Эстебан Молина-Эстолано; Амандип Хурана; Алекс Дж. Нельсон; Скотт А. Брандт; Мудрец Вейл (август 2010 г.). «Ceph как масштабируемая альтернатива распределенной файловой системе Hadoop». ;авторизоваться:. 35 (4). Получено 2012-03-09.

- Мартин Лошвиц (24 апреля 2012 г.). «Хранилище объектов RADOS и файловая система Ceph». Журнал HPC ADMIN. Получено 2012-04-25.

внешняя ссылка

| Искать κεφαλή в Викисловаре, бесплатном словаре. |

| Викискладе есть медиафайлы по теме Ceph. |