WikiDer > Наборы для обучения, проверки и тестирования

Эта статья нужны дополнительные цитаты для проверка. (Декабрь 2012 г.) (Узнайте, как и когда удалить этот шаблон сообщения) |

В машинное обучение, общей задачей является изучение и построение алгоритмы которые могут учиться и делать прогнозы данные.[1] Такие алгоритмы работают, делая прогнозы или решения на основе данных,[2] через создание математическая модель из исходных данных.

Данные, используемые для построения окончательной модели, обычно поступают из нескольких наборы данных. В частности, три набора данных обычно используются на разных этапах создания модели.

Модель изначально помещается на набор обучающих данных,[3] который представляет собой набор примеров, используемых для подбора параметров (например, веса связей между нейронами в искусственные нейронные сети) модели.[4] Модель (например, нейронная сеть или наивный байесовский классификатор) обучается на обучающем наборе данных с использованием контролируемое обучение метод, например, используя методы оптимизации, такие как градиентный спуск или же стохастический градиентный спуск. На практике обучающий набор данных часто состоит из пар входных данных. вектор (или скаляр) и соответствующий выходной вектор (или скаляр), где ключ ответа обычно обозначается как цель (или же метка). Текущая модель запускается с обучающим набором данных и дает результат, который затем сравнивается с цельдля каждого входного вектора в наборе обучающих данных. На основании результата сравнения и конкретного используемого алгоритма обучения настраиваются параметры модели. Подгонка модели может включать как выбор переменных и параметр оценка.

Последовательно подобранная модель используется для прогнозирования откликов для наблюдений во втором наборе данных, называемом набор данных проверки.[3] Набор данных проверки обеспечивает беспристрастную оценку соответствия модели набору обучающих данных при настройке модели. гиперпараметры[5] (например, количество скрытых единиц (слоев и ширины слоев) в нейронной сети[4]). Наборы данных проверки можно использовать для регуляризация к ранняя остановка (остановка обучения при увеличении ошибки в наборе данных проверки, так как это признак переоснащение к набору обучающих данных).[6]Эта простая процедура на практике усложняется тем фактом, что ошибка набора данных проверки может колебаться во время обучения, создавая несколько локальных минимумов. Это осложнение привело к созданию множества специальных правил для принятия решения о том, когда действительно началось переобучение.[6]

Наконец, тестовый набор данных набор данных, используемый для объективной оценки окончательный модель соответствует набору обучающих данных.[5] Если данные в тестовом наборе данных никогда не использовались при обучении (например, в перекрестная проверка) тестовый набор данных также называется набор данных удержания.

Набор данных для обучения

Набор обучающих данных - это набор данных примеров, используемых в процессе обучения, и используется для подбора параметров (например, весов), например, классификатор.[7][8]

Большинство подходов, которые ищут эмпирические взаимосвязи в обучающих данных, имеют тенденцию переобучать данные, что означает, что они могут идентифицировать и использовать очевидные взаимосвязи в данных обучения, которые в целом не соблюдаются.

Набор данных проверки

Набор данных проверки - это набор данных примеров, используемых для настройки гиперпараметры (то есть архитектура) классификатора. Иногда его также называют набором для разработки или «набором для разработчиков». Пример гиперпараметра для искусственные нейронные сети включает количество скрытых единиц в каждом слое.[7][8] Он, а также набор для тестирования (как упоминалось выше) должны следовать тому же распределению вероятностей, что и набор обучающих данных.

Чтобы избежать переобучения, когда классификация необходимо настроить параметр, необходимо иметь набор данных валидации в дополнение к наборам данных для обучения и тестирования. Например, если ищется наиболее подходящий классификатор для проблемы, обучающий набор данных используется для обучения алгоритмов-кандидатов, набор данных проверки используется для сравнения их характеристик и принятия решения, какой из них выбрать, и, наконец, набор тестовых данных используется для получить такие рабочие характеристики, как точность, чувствительность, специфичность, F-мера, и так далее. Набор данных проверки функционирует как гибрид: это обучающие данные, используемые для тестирования, но не как часть низкоуровневого обучения или как часть окончательного тестирования.

Базовый процесс использования набора данных проверки для выбор модели (как часть обучающего набора данных, набора данных проверки и набора тестовых данных):[8][9]

Поскольку наша цель - найти сеть, обладающую наилучшей производительностью на новых данных, самый простой подход к сравнению различных сетей - оценить функцию ошибок с использованием данных, которые не зависят от данных, используемых для обучения. Различные сети обучаются путем минимизации соответствующей функции ошибок, определенной для набора обучающих данных. Затем производительность сетей сравнивается путем оценки функции ошибок с использованием независимого набора проверки и выбирается сеть, имеющая наименьшую ошибку по сравнению с набором проверки. Такой подход называется продержаться метод. Поскольку эта процедура сама по себе может привести к некоторому переоснащению набора для проверки, производительность выбранной сети должна быть подтверждена путем измерения ее производительности на третьем независимом наборе данных, называемом набором тестов.

Приложение этого процесса находится в ранняя остановка, где модели-кандидаты являются последовательными итерациями одной и той же сети, а обучение останавливается, когда ошибка на проверочном наборе растет, выбирая предыдущую модель (модель с минимальной ошибкой).

Набор тестовых данных

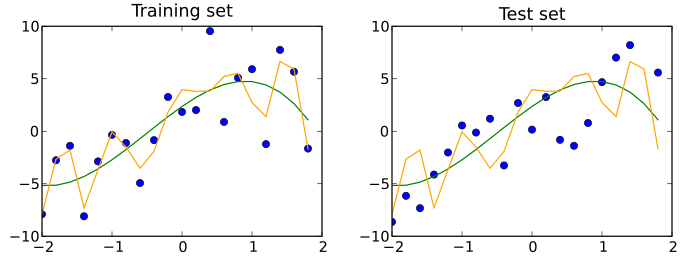

Набор тестовых данных - это набор данных то есть независимый обучающего набора данных, но это следует за тем же распределение вероятностей в качестве набора данных для обучения. Если модель подходит для обучающего набора данных также хорошо подходит для тестового набора данных, минимальный переоснащение произошло (см. рисунок ниже). Лучшее соответствие набора обучающих данных по сравнению с набором тестовых данных обычно указывает на переобучение.

Таким образом, набор тестов - это набор примеров, используемых только для оценки производительности (т. Е. Обобщения) полностью определенного классификатора.[7][8]

Набор данных Holdout

Часть исходного набора данных можно отложить и использовать в качестве тестового набора: это известно как метод удержания.[10]

Путаница в терминологии

Условия набор тестов и набор для проверки иногда используются таким образом, что их значение переворачивается как в промышленности, так и в академических кругах. При ошибочном использовании «набор тестов» становится набором для разработки, а «набор для проверки» - это независимый набор, используемый для оценки производительности полностью указанного классификатора.

В литературе по машинному обучению часто используются противоположные значения «проверочных» и «тестовых». Это наиболее вопиющий пример терминологической путаницы, которая пронизывает исследования искусственного интеллекта.[11]

Перекрестная проверка

Набор данных можно многократно разделить на набор данных для обучения и набор данных для проверки: это известно как перекрестная проверка. Эти повторяющиеся разделы могут быть выполнены различными способами, например, разделением на 2 равных набора данных и использованием их в качестве обучения / проверки, а затем проверки / обучения или повторного выбора случайного подмножества в качестве набора данных проверки.[нужна цитата]. Для проверки производительности модели иногда используется дополнительный набор тестовых данных, который не прошел перекрестную проверку.[нужна цитата]

Иерархическая классификация

Другой пример настройки параметров: иерархическая классификация (иногда называют разложение пространства экземпляров[12]), который разбивает полную многоклассовую задачу на набор более мелких задач классификации. Он служит для изучения более точных концепций благодаря более простым границам классификации в подзадачах и процедурам выбора отдельных функций для подзадач. При выполнении декомпозиции классификации центральным выбором является порядок объединения более мелких этапов классификации, называемый путем классификации. В зависимости от приложения его можно получить из матрица путаницы а также выявление причин типичных ошибок и поиск способов предотвращения их появления в системе. Например,[13] на наборе проверки можно увидеть, какие классы наиболее часто взаимно путаются системой, а затем декомпозиция пространства экземпляров выполняется следующим образом: во-первых, классификация выполняется среди хорошо узнаваемых классов, а классы, которые трудно разделить, рассматриваются как единый объединенный класс и, наконец, на втором этапе классификации объединенный класс классифицируется на два первоначально смешанных класса.[нужна цитата]

Смотрите также

Рекомендации

- ^ Рон Кохави; Фостер-провост (1998). "Словарь терминов". Машинное обучение. 30: 271–274. Дои:10.1023 / А: 1007411609915.

- ^ Епископ, Кристофер М. (2006). Распознавание образов и машинное обучение. Нью-Йорк: Спрингер. п. vii. ISBN 0-387-31073-8.

Распознавание образов берет свое начало в инженерии, тогда как машинное обучение выросло из информатики. Однако эти виды деятельности можно рассматривать как две стороны одной и той же области, и вместе они претерпели существенное развитие за последние десять лет.

- ^ а б Джеймс, Гарет (2013). Введение в статистическое обучение: с приложениями в R. Springer. п. 176. ISBN 978-1461471370.

- ^ а б Рипли, Брайан (1996). Распознавание образов и нейронные сети. Издательство Кембриджского университета. п.354. ISBN 978-0521717700.

- ^ а б Браунли, Джейсон (13.07.2017). «В чем разница между тестовыми и проверочными наборами данных?». Получено 2017-10-12.

- ^ а б Прешельт, Лутц; Женевьева Б. Орр (01.01.2012). «Ранняя остановка - но когда?». В Грегуаре Монтавоне; Клаус-Роберт Мюллер (ред.). Нейронные сети: хитрости торговли. Конспект лекций по информатике. Springer Berlin Heidelberg. стр.53–67. Дои:10.1007/978-3-642-35289-8_5. ISBN 978-3-642-35289-8.

- ^ а б c Рипли, Б. (1996) Распознавание образов и нейронные сети, Кембридж: Издательство Кембриджского университета, стр. 354

- ^ а б c d "Тема: Что такое генеральная совокупность, выборка, обучающий набор, проектный набор, набор для проверки и набор тестов?", Часто задаваемые вопросы о нейронных сетях, часть 1 из 7: Введение (текст), comp.ai.neural-nets, Sarle, W.S., ed. (1997 г., последнее изменение 17 мая 2002 г.)

- ^ Бишоп, К. (1995), Нейронные сети для распознавания образов, Oxford: Oxford University Press, стр. 372

- ^ Кохави, Рон (2001-03-03). «Исследование перекрестной проверки и начальной загрузки для оценки точности и выбора модели». 14. Цитировать журнал требует

| журнал =(помощь) - ^ Рипли, Брайан Д. (2009). Распознавание образов и нейронные сети. Cambridge Univ. Нажмите. С. Глоссарий. ISBN 9780521717700. OCLC 601063414.

- ^ Cohen, S .; Рокач, Л .; Маймон, О. (2007). «Декомпозиция пространства экземпляров дерева решений с сгруппированным коэффициентом усиления». Информационные науки. Эльзевир. 177 (17): 3592–3612. Дои:10.1016 / j.ins.2007.01.016.

- ^ Сидорова Дж., Бадиа Т. "ESEDA: инструмент для расширенного обнаружения и анализа речевых эмоций". 4-я Международная конференция по автоматизированным решениям для кросс-медиа контента и многоканального распространения (AXMEDIS 2008). Флоренция, 17-19 ноября, стр. 257–260. IEEE press.

внешняя ссылка

- Часто задаваемые вопросы: что такое генеральная совокупность, выборка, обучающий набор, проектный набор, набор для проверки и набор тестов?

- В чем разница между тестовыми и проверочными наборами данных?

- Что такое сценарий обучения, проверки и тестирования наборов данных в машинном обучении?

- Есть ли практическое правило, как разделить набор данных на обучающий и проверочный наборы?