WikiDer > Глубокое обучение с подкреплением

Глубокое обучение с подкреплением (глубокий RL) является подполем машинное обучение это объединяет обучение с подкреплением (RL) и глубокое обучение. RL рассматривает проблему научения вычислительного агента принимать решения методом проб и ошибок. Deep RL включает в себя глубокое обучение в решении, позволяя агентам принимать решения на основе неструктурированных входных данных без ручного проектирования пространств состояний. Алгоритмы глубокого RL могут принимать очень большие входные данные (например, каждый пиксель, отображаемый на экране в видеоигре) и решать, какие действия выполнять для оптимизации цели (например, максимизировать игровой счет). Глубокое обучение с подкреплением использовалось для разнообразного набора приложений, включая, помимо прочего, робототехника, видеоигры, обработка естественного языка, компьютерное зрение, образование, транспорт, финансы и здравоохранение.[1]

Обзор

Глубокое обучение

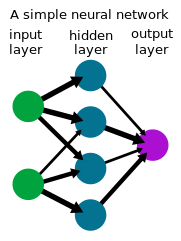

Глубокое обучение это форма машинное обучение который использует нейронную сеть для преобразования набора входов в набор выходов через искусственная нейронная сеть. Методы глубокого обучения, часто использующие контролируемое обучение с помеченными наборами данных, были показаны для решения задач, связанных с обработкой сложных, многомерных необработанных входных данных, таких как изображения, с меньшим количеством ручного разработка функций по сравнению с предыдущими методами, что позволило добиться значительного прогресса в нескольких областях, включая компьютерное зрение и обработка естественного языка.

Обучение с подкреплением

Обучение с подкреплением это процесс, в котором агент учится принимать решения методом проб и ошибок. Эта проблема часто моделируется математически как Марковский процесс принятия решений (MDP), где агент на каждом временном шаге находится в состоянии , принимает меры , получает скалярное вознаграждение и переходит в следующее состояние согласно динамике окружающей среды . Агент пытается изучить политику чтобы максимизировать отдачу (ожидаемая сумма вознаграждения). В обучении с подкреплением (в отличие от оптимальный контроль) алгоритм имеет доступ только к динамике посредством отбора проб.

Глубокое обучение с подкреплением

Во многих практических задачах принятия решений государства MDP являются многомерными (например, изображения с камеры или необработанный поток датчика от робота) и не могут быть решены с помощью традиционных алгоритмов RL. Алгоритмы глубокого обучения с подкреплением включают глубокое обучение для решения таких MDP, часто представляя политику или другие изученные функции в качестве нейронной сети, а также разработка специализированных алгоритмов, которые хорошо работают в этих условиях.

История

Наряду с растущим интересом к нейронным сетям, начиная с середины 1980-х, вырос интерес к глубокому обучению с подкреплением, когда нейронная сеть используется для представления политик или функций ценностей. Как и в такой системе, весь процесс принятия решений от датчиков до двигателей в роботе или агенте включает однослойный нейронная сеть, его иногда называют сквозным обучением с подкреплением.[2] Одним из первых успешных приложений обучения с подкреплением с помощью нейронных сетей было TD-Gammon, компьютерная программа, разработанная в 1992 году для игры нарды.[3] Четыре входа использовались для количества элементов данного цвета в заданном месте на плате, всего 198 входных сигналов. Имея нулевые знания, сеть научилась играть в игру на промежуточном уровне путем самостоятельной игры и TD ().

Базовые учебники Sutton и Барто по обучению с подкреплением,[4] Бертсекас и Цитиклис по нейродинамическому программированию,[5] и другие[6] передовые знания и интерес к этой области. Группа Кацунари Шибата показала, что в этой структуре появляются различные функции,[7][8][9] включая распознавание изображений, постоянство цвета, движение датчика (активное распознавание), зрительно-моторную координацию и движение руки, объяснение активности мозга, передачу знаний, память,[10] избирательное внимание, предсказание и исследование.[8][11]

Примерно с 2013 г. DeepMind показал впечатляющие результаты обучения с использованием глубокого RL для игры Atari видеоигры.[12][13] Компьютерный проигрыватель нейронной сети, обученной с использованием алгоритма глубокого RL, глубокой версии Q-обучение они назвали «глубокие Q-сети» (DQN), в которых в качестве награды использовался счет в игре. Они использовали глубокий сверточная нейронная сеть для обработки 4-х кадровых пикселей RGB (84x84) в качестве входных данных. Все 49 игр были изучены с использованием одной и той же сетевой архитектуры и с минимальными предварительными знаниями, которые превосходят конкурирующие методы почти во всех играх и работают на уровне, сопоставимом или превосходящем с уровнем профессионального тестировщика игр.[13]

В 2015 году глубокое обучение с подкреплением стало важной вехой, когда AlphaGo,[14] компьютерная программа, обученная с глубоким RL играть Идти, стала первой компьютерной программой Го, которая обыграла профессионального игрока в Го без гандикапа на полноразмерной доске 19 × 19. В следующем проекте в 2017 году AlphaZero улучшенная производительность на Go, а также демонстрация того, что они могут использовать тот же алгоритм, чтобы научиться играть шахматы и сёги на уровне, конкурентоспособном или превосходящем существующие компьютерные программы для этих игр. Отдельно еще одну веху достигли исследователи из Университет Карнеги Меллон в 2019 году развивается Pluribus, компьютерная программа для игры покер первым обошел профессионалов в многопользовательских безлимитных играх. Техасский холдем. OpenAI Five, программа для игры пять на пять Dota 2 обыграть предыдущих чемпионов мира в показательном матче 2019 года.

Глубокое обучение с подкреплением также применяется во многих областях, помимо игр. В робототехнике он использовался, чтобы позволить роботам выполнять простые домашние дела. [15] и собрать кубик Рубика рукой робота.[16] Deep RL также нашла приложения для обеспечения устойчивости, которые используются для снижения потребления энергии в центрах обработки данных.[17] Глубокий RL для автономное вождение является активной областью научных исследований и исследований в промышленности.[18]

Алгоритмы

Существуют различные методы обучения политик решению задач с помощью алгоритмов глубокого обучения с подкреплением, каждый из которых имеет свои преимущества. На самом высоком уровне существует различие между обучением с подкреплением на основе моделей и без модели, которое относится к тому, пытается ли алгоритм изучить прямую модель динамики среды.

В модельный алгоритмы глубокого обучения с подкреплением, прогнозная модель динамики среды оценивается, как правило, контролируемое обучение с помощью нейронной сети. Тогда действия получаются с помощью прогнозирующий контроль модели используя изученную модель. Поскольку истинная динамика окружающей среды обычно отличается от усвоенной динамики, агент часто перепланирует свои действия при выполнении действий в окружающей среде. Выбранные действия можно оптимизировать с помощью Методы Монте-Карло такой как кросс-энтропийный метод, или сочетание обучения модели с методами без модели, описанными ниже.

В безмодельный алгоритмы глубокого обучения с подкреплением, политика изучается без явного моделирования прямой динамики. Политику можно оптимизировать для максимизации прибыли путем непосредственной оценки градиента политики.[19] но страдает высокой дисперсией, что делает его непрактичным для использования с приближением функций в глубоком RL. Последующие алгоритмы были разработаны для более стабильного обучения и широко применяются.[20][21] Другой класс безмодельных алгоритмов обучения с глубоким подкреплением полагается на динамическое программирование, вдохновленный обучение разнице во времени и Q-обучение. В пространствах дискретных действий эти алгоритмы обычно изучают Q-функцию нейронной сети. который оценивает будущую прибыль, принимая меры от государства .[12] В непрерывных пространствах эти алгоритмы часто изучают как оценку стоимости, так и политику.[22][23][24]

Исследование

Глубокое обучение с подкреплением - активная область исследований. Ниже приведены некоторые из основных направлений расследования.

Исследование

Агент RL должен уравновесить компромисс между исследованием и эксплуатацией: проблема принятия решения о том, предпринимать ли действия, которые, как известно, приносят высокие награды, или исследовать другие действия, чтобы получить более высокие награды. Агенты RL обычно собирают данные с помощью некоторого типа стохастической политики, например Распределение Больцмана в дискретных пространствах действий или Гауссово распределение в пространствах непрерывного действия, вызывая базовое исследовательское поведение. Идея, лежащая в основе исследования, основанного на новизне или любопытстве, дает агенту повод исследовать неизвестные результаты, чтобы найти лучшие решения. Это делается путем «изменения функции потерь (или даже сетевой архитектуры) путем добавления условий, стимулирующих исследования».[25] Агенту также можно помочь в исследовании, используя демонстрацию успешных траекторий или формирование вознаграждения, давая агенту промежуточные вознаграждения, которые настраиваются в соответствии с задачей, которую он пытается выполнить.[26]

Обучение с подкреплением вне политики

Важное различие в RL - это разница между алгоритмами на основе политики, которые требуют оценки или улучшения политики, которая собирает данные, и алгоритмами вне политики, которые могут изучать политику из данных, сгенерированных произвольной политикой. Как правило, методы, основанные на функциях ценности, лучше подходят для обучения вне политики и имеют лучшую эффективность выборки - объем данных, необходимых для изучения задачи, уменьшается, поскольку данные повторно используются для обучения. В крайнем случае, автономный (или «пакетный») RL рассматривает возможность изучения политики из фиксированного набора данных без дополнительного взаимодействия со средой.

Обратное обучение с подкреплением

Обратный RL относится к выводу функции вознаграждения агента с учетом поведения агента. Обратное обучение с подкреплением можно использовать для обучения на демонстрациях (или ученичество), сделав вывод о вознаграждении демонстратора и затем оптимизируя политику, чтобы максимизировать отдачу с помощью RL. Подходы глубокого обучения использовались для различных форм имитационного обучения и обратного RL.

Обучение с подкреплением, обусловленным целью

Еще одна активная область исследований - изучение политики, обусловленной целью, также называемой контекстной или универсальной политикой. которые берут на себя дополнительную цель в качестве входных данных для сообщения агенту желаемой цели.[27] Воспроизведение ретроспективного опыта - это метод для обусловленного целью RL, который включает в себя сохранение и извлечение уроков из предыдущих неудачных попыток выполнить задачу.[28] Хотя неудачная попытка могла не достичь намеченной цели, она может послужить уроком о том, как достичь непреднамеренного результата путем перемаркировки задним числом.

Многоагентное обучение с подкреплением

Многие приложения обучения с подкреплением включают не только одного агента, а скорее набор агентов, которые учатся вместе и совместно адаптируются. Эти агенты могут быть конкурентными, как во многих играх, или кооперативными, как во многих реальных многоагентных системах.

Обобщение

Обещание использования инструментов глубокого обучения в обучении с подкреплением является обобщением: способность правильно работать с ранее невидимыми входными данными. Например, нейронные сети, обученные распознаванию изображений, могут распознать, что изображение содержит птицу, даже если они никогда не видели это конкретное изображение или даже эту конкретную птицу. Поскольку глубокий RL допускает необработанные данные (например, пиксели) в качестве входных данных, уменьшается потребность в предварительном определении среды, что позволяет обобщить модель для нескольких приложений. С помощью этого уровня абстракции алгоритмы глубокого обучения с подкреплением могут быть разработаны таким образом, чтобы они были общими, а одну и ту же модель можно было использовать для разных задач.[29] Один из методов повышения способности политик, обученных с помощью политик глубокого RL, к обобщению - это включение репрезентативное обучение.

использованная литература

- ^ Франсуа-Лаве, Винсент; Хендерсон, Питер; Ислам, Риашат; Bellemare, Marc G .; Пино, Жоэль (2018). «Введение в глубокое обучение с подкреплением». Основы и тенденции в машинном обучении. 11 (3–4): 219–354. arXiv:1811.12560. Bibcode:2018arXiv181112560F. Дои:10.1561/2200000071. ISSN 1935-8237. S2CID 54434537.

- ^ Демис, Хассабис (11 марта 2016 г.). Искусственный интеллект и будущее (Речь).

- ^ Тесауро, Джеральд (март 1995). "Изучение временной разницы и TD-Gammon". Коммуникации ACM. 38 (3): 58–68. Дои:10.1145/203330.203343. Архивировано из оригинал на 2010-02-09. Получено 2017-03-10.

- ^ Саттон, Ричард; Барто, Эндрю (сентябрь 1996 г.). Обучение с подкреплением: введение. Athena Scientific.

- ^ Бертсекас, Джон; Цициклис, Дмитрий (сентябрь 1996 г.). Нейродинамическое программирование. Athena Scientific. ISBN 1-886529-10-8.

- ^ Миллер, В. Томас; Вербос, Пол; Саттон, Ричард (1990). Нейронные сети для управления.

- ^ Шибата, Кацунари; Окабе, Йоичи (1997). Обучение с подкреплением, когда зрительные сенсорные сигналы используются непосредственно в качестве входных данных (PDF). Международная конференция по нейронным сетям (ICNN) 1997.

- ^ а б Шибата, Кацунари; Иида, Масару (2003). Приобретение Box Pushing с помощью обучения с подкреплением на основе Direct-Vision (PDF). Ежегодная конференция SICE 2003.

- ^ Шибата, Кацунари (7 марта 2017 г.). «Функции, возникающие благодаря непрерывному обучению с подкреплением». arXiv:1703.02239 [cs.AI].

- ^ Уцуномия, Хироки; Шибата, Кацунари (2008). Контекстное поведение и внутренние представления, полученные в результате обучения с подкреплением с помощью рекуррентной нейронной сети в задаче непрерывного состояния и пространства действий (PDF). Международная конференция по обработке нейронной информации (ICONIP) '08.[постоянная мертвая ссылка]

- ^ Шибата, Кацунари; Кавано, Томохико (2008). Изучение генерации действий из необработанных изображений с камеры в реальной среде с помощью простого соединения обучения с подкреплением и нейронной сети (PDF). Международная конференция по обработке нейронной информации (ICONIP) '08.

- ^ а б Мних, Владимир; и другие. (Декабрь 2013). Игра в Atari с глубоким обучением с подкреплением (PDF). NIPS Deep Learning Workshop 2013.

- ^ а б Мних, Владимир; и другие. (2015). «Контроль на уровне человека посредством глубокого обучения с подкреплением». Природа. 518 (7540): 529–533. Bibcode:2015Натура.518..529M. Дои:10.1038 / природа14236. PMID 25719670.

- ^ Сильвер, Дэвид; Хуанг, Аджа; Мэддисон, Крис Дж .; Гез, Артур; Сифре, Лоран; Дрише, Джордж ван ден; Шриттвизер, Джулиан; Антоноглоу, Иоаннис; Паннеершелвам, Веда; Ланкто, Марк; Дилеман, Сандер; Греве, Доминик; Нхам, Джон; Кальхбреннер, Нал; Суцкевер Илья; Лилликрап, Тимоти; Лич, Мадлен; Кавукчуоглу, Корай; Грэпель, Тор; Хассабис, Демис (28 января 2016 г.). «Освоение игры го с глубокими нейронными сетями и поиском по дереву». Природа. 529 (7587): 484–489. Bibcode:2016Натура.529..484S. Дои:10.1038 / природа16961. ISSN 0028-0836. PMID 26819042.

- ^ Левин, Сергей; Финн, Челси; Даррелл, Тревор; Аббель, Питер (январь 2016 г.). «Комплексное обучение глубокой зрительно-моторной политике» (PDF). JMLR. 17.

- ^ «OpenAI - Сборка кубика Рубика с помощью руки робота». OpenAI.

- ^ «DeepMind AI снижает счет за охлаждение центра обработки данных Google на 40%». DeepMind.

- ^ Хотц, Джордж (сентябрь 2019 г.). «Победа - подход к обучению с подкреплением» (Интервью). Беседовал Лекс Фридман.

- ^ Уильямс, Рональд Дж (1992). «Простые статистические алгоритмы следования градиентам для обучения с подкреплением коннекционистов». Машинное обучение: 229–256.

- ^ Шульман, Джон; Левин, Сергей; Мориц, Филипп; Джордан, Майкл; Аббель, Питер (2015). Оптимизация политики доверенного региона. Международная конференция по машинному обучению (ICML).

- ^ Шульман, Джон; Вольски, Филип; Дхаривал, Прафулла; Рэдфорд, Алек; Климов, Олег (2017). Алгоритмы проксимальной оптимизации политики.

- ^ Лилликрап, Тимоти; Хант, Джонатан; Прицель, Александр; Хесс, Николас; Эрез, Том; Тасса, Юваль; Сильвер, Дэвид; Виерстра, Даан (2016). Непрерывный контроль с глубоким обучением с подкреплением. Международная конференция по обучающим представительствам (ICLR).

- ^ Мних, Владимир; Пуигдоменек Бадиа, Адрия; Мирзи, Мехди; Грейвс, Алекс; Харли, Тим; Лилликрап, Тимоти; Сильвер, Дэвид; Кавукчуоглу, Корай (2016). Асинхронные методы обучения с глубоким подкреплением. Международная конференция по машинному обучению (ICML).

- ^ Хаарноя, Туомас; Чжоу, Аурик; Левин, Сергей; Аббель, Питер (2018). Мягкий критик-субъект: обучение с глубоким подкреплением с максимальной энтропией вне политики со стохастическим субъектом. Международная конференция по машинному обучению (ICML).

- ^ Райзингер, Патрик; Семеньей, Мартон (23.10.2019). «Исследование, основанное на внимании и любопытстве, в обучении с глубоким подкреплением». arXiv: 1910.10840 [cs, stat].

- ^ Wiewiora, Эрик (2010), Саммут, Клод; Уэбб, Джеффри И. (ред.), «Формирование награды», Энциклопедия машинного обучения, Бостон, Массачусетс: Springer US, стр. 863–865, Дои:10.1007/978-0-387-30164-8_731, ISBN 978-0-387-30164-8, получено 2020-11-16

- ^ Шауль, Том; Хорган, Дэниел; Грегор, Кароль; Серебро, Дэвид (2015). Аппроксиматоры универсальной функции значений. Международная конференция по машинному обучению (ICML).

- ^ Андрыхович, Марцин; Вольски, Филип; Рэй, Алекс; Шнайдер, Йонас; Фонг, Рэйчел; Велиндер, Питер; МакГрю, Боб; Тобин, Джош; Аббель, Питер; Заремба, Войцех (2018). Воспроизведение ретроспективного опыта. Достижения в системах обработки нейронной информации (NeurIPS).

- ^ Пакер, Чарльз; Гао, Кейтлин; Кос, Ерней; Крахенбюль, Филипп; Колтун, Владлен; Песня, Рассвет (2019-03-15). «Оценка обобщения в обучении с глубоким подкреплением». arXiv: 1810.12282 [cs, stat].