WikiDer > Гауссовский процесс

В теория вероятности и статистика, а Гауссовский процесс это случайный процесс (набор случайных величин, проиндексированных по времени или пространству), так что каждый конечный набор этих случайных величин имеет многомерное нормальное распределение, т.е. каждое конечное линейная комбинация из них нормально распространяется. Распределение гауссовского процесса - это совместное распределение всех этих (бесконечно многих) случайных величин, и как таковое, это распределение по функциям с непрерывной областью определения, например время или пространство.

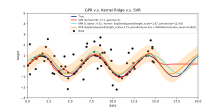

Алгоритм машинного обучения, включающий гауссовский процесс, использует ленивое обучение и мера сходства между точками ( функция ядра), чтобы предсказать значение невидимой точки из обучающих данных. Прогноз - это не только оценка для этой точки, но и информация о неопределенности - это одномерное распределение Гаусса.[1]Для прогнозирования с несколькими выходами многомерные гауссовские процессы[2][3] используются, для которых многомерное распределение Гаусса - предельное распределение в каждой точке.

Для некоторых функций ядра матричная алгебра может использоваться для вычисления прогнозов с использованием техники кригинг. Когда используется параметризованное ядро, программное обеспечение оптимизации обычно используется для соответствия гауссовской модели процесса.

Концепция гауссовских процессов названа в честь Карл Фридрих Гаусс поскольку он основан на понятии гауссова распределения (нормальное распределение). Гауссовские процессы можно рассматривать как бесконечномерное обобщение многомерных нормальных распределений.

Гауссовские процессы полезны в статистическое моделирование, используя свойства, унаследованные от нормального распределения. Например, если случайный процесс моделируется как гауссовский процесс, распределения различных производных величин могут быть получены явно. Такие величины включают среднее значение процесса за определенный период времени и ошибку при оценке среднего значения с использованием значений выборки за небольшой набор времен. Хотя точные модели часто плохо масштабируются по мере увеличения объема данных, несколько методы аппроксимации были разработаны, которые часто сохраняют хорошую точность, резко сокращая время вычислений.

Определение

Время непрерывное случайный процесс гауссовский если и только если для каждого конечный набор из индексы в индексном наборе

это многомерный гауссовский случайная переменная.[4] Это то же самое, что сказать любую линейную комбинацию имеет одномерное нормальное (или гауссово) распределение.

С помощью характеристические функции случайных величин свойство Гаусса можно сформулировать следующим образом: гауссовский тогда и только тогда, когда для каждого конечного набора индексов , есть ценные , с такое, что для всех

- .

куда обозначает мнимая единица такой, что .

Цифры и можно показать как ковариации и средства переменных в процессе.[5]

Дисперсия

Дисперсия гауссовского процесса конечна в любое время , формально[6]:п. 515

- .

Стационарность

Для общих случайных процессов стационарность в строгом смысле слова подразумевает стационарность в широком смысле но не всякий стационарный случайный процесс в широком смысле является стационарным в строгом смысле слова. Однако для гауссовского случайного процесса эти две концепции эквивалентны.[6]:п. 518

Гауссовский случайный процесс является стационарным в строгом смысле слова тогда и только тогда, когда он стационарен в широком смысле.

Пример

Есть явное представление для стационарных гауссовских процессов.[7] Простой пример этого представления:

куда и независимые случайные величины с стандартное нормальное распределение.

Ковариационные функции

Ключевым фактом гауссовских процессов является то, что они могут быть полностью определены их статистикой второго порядка.[8] Таким образом, если предположить, что гауссовский процесс имеет нулевое среднее значение, определение ковариационная функция полностью определяет поведение процесса. Важно отметить, что неотрицательная определенность этой функции дает возможность ее спектрального разложения с использованием Расширение Карунена – Лоэва. Основные аспекты, которые могут быть определены с помощью функции ковариации, - это процесс стационарность, изотропия, гладкость и периодичность.[9][10]

Стационарность относится к поведению процесса относительно разделения любых двух точек и . Если процесс стационарный, это зависит от их разделения, , а если он нестационарный, это зависит от фактического положения точек и . Например, частный случай Процесс Орнштейна – Уленбека, а Броуновское движение процесс, является стационарным.

Если процесс зависит только от , евклидово расстояние (не направление) между и , то процесс считается изотропным. Процесс, который одновременно является стационарным и изотропным, считается однородный;[11] на практике эти свойства отражают различия (или, скорее, их отсутствие) в поведении процесса с учетом местоположения наблюдателя.

В конечном итоге гауссовские процессы переводятся как априорные функции, и гладкость этих априорных значений может быть индуцирована ковариационной функцией.[9] Если мы ожидаем, что для "близких" точек ввода и их соответствующие выходные точки и быть "рядом" тоже, то предположение о непрерывности присутствует. Если мы хотим учесть значительное смещение, мы могли бы выбрать более грубую ковариационную функцию. Крайними примерами такого поведения являются ковариационная функция Орнштейна – Уленбека и квадрат экспоненты, где первая никогда не дифференцируема, а вторая - бесконечно дифференцируема.

Под периодичностью понимается создание периодических закономерностей в поведении процесса. Формально это достигается отображением входных данных в двумерный вектор .

Обычные ковариационные функции

Существует ряд общих ковариационных функций:[10]

- Постоянный :

- Линейный:

- белый гауссов шум:

- Квадрат экспоненты:

- Орнштейн – Уленбек:

- Матерн:

- Периодический:

- Рациональный квадратичный:

Здесь . Параметр - характерный масштаб процесса (практически «насколько близко» две точки и должны существенно влиять друг на друга), это Дельта Кронекера и в стандартное отклонение шумовых колебаний. Более того, это модифицированная функция Бесселя порядка и это гамма-функция оценивается в . Важно отметить, что сложная ковариационная функция может быть определена как линейная комбинация других более простых ковариационных функций для включения различных представлений о доступном наборе данных.

Ясно, что выводимые результаты зависят от значений гиперпараметров. (например. и ), определяющие поведение модели. Популярный выбор для должен предоставить максимум апостериори (MAP) оценки этого с некоторыми выбранными предварительными. Если априор очень близок к однородному, это то же самое, что и максимизация предельная вероятность процесса; маргинализация осуществляется по наблюдаемым значениям процесса .[10] Этот подход также известен как максимальная вероятность II, максимизация доказательств, или же эмпирический байесовский.[12]

Непрерывность

Для гауссовского процесса непрерывность вероятности эквивалентно среднеквадратичная непрерывность,[13]:145и непрерывность с вероятностью один эквивалентно непрерывность образца.[14]:91 «Гауссовские процессы разрывны в фиксированных точках».Последнее предполагает, но не подразумевается, непрерывность вероятности. Непрерывность вероятности имеет место тогда и только тогда, когда среднее и автоковариантность являются непрерывными функциями. Напротив, непрерывность выборки была сложной задачей даже для стационарные гауссовские процессы (как, вероятно, первым заметил Андрей Колмогоров), и сложнее для более общих процессов.[15]:Разд. 2,8[16]:69,81[17]:80[18]Как обычно, под непрерывным процессом пробы понимается процесс, который допускает непрерывный образец модификация.[19]:292[20]:424

Стационарный корпус

Для стационарного гауссовского процесса некоторые условия на его спектр достаточны для непрерывности образца, но не являются необходимыми. Необходимое и достаточное условие, иногда называемое теоремой Дадли-Фернике, включает функцию определяется

(правая часть не зависит от из-за стационарности). Непрерывность по вероятности эквивалентна непрерывности в При сближении к (в качестве ) слишком медленно, непрерывность образца может потерпеть неудачу. Имеет значение сходимость следующих интегралов:

эти два интеграла равны согласно интеграция путем замены Первое подынтегральное выражение не нужно ограничивать как таким образом, интеграл может сходиться () или расходятся (). Взяв, например, для больших то есть, для маленьких можно получить когда и когда В этих двух случаях функция увеличивается на но обычно это не так. Кроме того, условие

- Существует такой, что монотонно на

не следует из преемственности и очевидные отношения (для всех ) и

Теорема 1. Позволять быть непрерывным и удовлетворять Тогда условие необходимо и достаточно для непрерывности образца

Немного истории.[20]:424Достаточность объявлена Ксавье Ферник в 1964 г., но первое доказательство было опубликовано Ричард М. Дадли в 1967 г.[19]:Теорема 7.1.Необходимость была доказана Майклом Б. Маркусом и Лоуренс Шепп в 1970 г.[21]:380

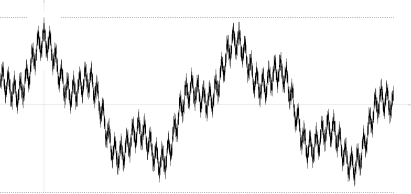

Существуют образцы непрерывных процессов такой, что они нарушают условие Пример, найденный Маркусом и Шеппом [21]:387 случайный лакунарный ряд Фурье

куда независимые случайные величины с стандартное нормальное распределение; частоты являются быстрорастущей последовательностью; и коэффициенты удовлетворить Последнее соотношение подразумевает откуда почти наверняка, что обеспечивает равномерную сходимость ряда Фурье почти наверняка, а выборочную непрерывность

Его автоковариационная функция

нигде не монотонна (см. рисунок), как и соответствующая функция

Броуновское движение как интеграл гауссовских процессов

А Винеровский процесс (он же броуновское движение) является интегралом обобщенный гауссовский процесс белого шума. Это не так стационарный, но имеет стационарные приращения.

В Процесс Орнштейна – Уленбека это стационарный Гауссовский процесс.

В Броуновский мост является (как и процесс Орнштейна – Уленбека) примером гауссовского процесса, приращения которого не являются независимый.

В дробное броуновское движение является гауссовским процессом, ковариационная функция которого является обобщением ковариационной функции винеровского процесса.

Закон нуля или единицы Дрисколла

Закон нуля или единицы Дрисколла - это результат, характеризующий выборочные функции, генерируемые гауссовским процессом.

Позволять - гауссовский процесс с нулевым средним с неотрицательно определенной ковариационной функцией . Позволять быть Воспроизведение ядра гильбертова пространства с положительно определенным ядром .

потом

- ,

куда и ковариационные матрицы всех возможных пар очков, подразумевает

- .

Более того,

подразумевает

- .[22]

Это имеет серьезные последствия, когда , так как

- .

Таким образом, почти все выборочные пути гауссовского процесса с нулевым средним и положительно определенным ядром будет лежать вне гильбертова пространства .

Гауссовские процессы с линейными ограничениями

Для многих интересных приложений уже даны некоторые ранее существовавшие знания о системе. Рассмотрим, например, случай, когда выход гауссова процесса соответствует магнитному полю; здесь реальное магнитное поле ограничено уравнениями Максвелла, и было бы желательно включить это ограничение в формализм гауссовского процесса, поскольку это, вероятно, улучшило бы точность алгоритма.

Метод включения линейных ограничений в гауссовские процессы уже существует:[23]

Рассмотрим (векторную) выходную функцию который, как известно, подчиняется линейному ограничению (т.е. является линейным оператором)

Тогда ограничение можно выполнить, выбрав , куда моделируется как гауссовский процесс, и нахождение s.t.

Данный и используя тот факт, что гауссовские процессы замкнуты относительно линейных преобразований, гауссовский процесс для подчиняться принуждению становится

Следовательно, линейные ограничения могут быть закодированы в среднее значение и ковариационную функцию гауссовского процесса.

Приложения

Гауссовский процесс можно использовать как априорное распределение вероятностей над функции в Байесовский вывод.[10][25] Учитывая любой набор N точек в желаемой области ваших функций, возьмите многомерный гауссовский чья ковариация матрица параметр - это Матрица Грама вашей N точки с некоторыми желательными ядро, и образец от этого гауссовского. Для решения задачи прогнозирования с несколькими выходами была разработана регрессия гауссовского процесса для векторнозначной функции. В этом методе строится «большая» ковариация, которая описывает корреляции между всеми входными и выходными переменными, взятыми в N точки в желаемом домене.[26] Этот подход был подробно разработан для матричнозначных гауссовских процессов и обобщен на процессы с «более тяжелыми хвостами», такими как Студенческие процессы.[3]

Вывод непрерывных значений с помощью предшествующего гауссовского процесса известен как регрессия гауссовского процесса, или кригинг; расширение регрессии гауссовского процесса до несколько целевых переменных известен как кокригинг.[27] Таким образом, гауссовские процессы полезны как мощная нелинейная многомерная интерполяция инструмент. Гауссовская регрессия процесса может быть расширена для решения задач обучения как в под наблюдением (например, вероятностная классификация[10]) и без присмотра (например. многообразное обучение[8]) учебные рамки.

Гауссовские процессы также могут использоваться, например, в контексте смешанных моделей экспертов.[28][29] Основное обоснование такой структуры обучения состоит в предположении, что данное отображение не может быть хорошо охвачено одной гауссовой моделью процесса. Вместо этого пространство наблюдения разделено на подмножества, каждое из которых характеризуется различной функцией отображения; каждый из них изучается через разные компоненты гауссовского процесса в постулируемой смеси.

Прогнозирование гауссовского процесса или кригинг

При рассмотрении общей задачи регрессии гауссовского процесса (кригинга) предполагается, что для гауссовского процесса наблюдается в координатах , вектор значений это всего лишь один образец из многомерного гауссовского распределения размерности, равной количеству наблюдаемых координат . Следовательно, в предположении распределения с нулевым средним , куда ковариационная матрица между всеми возможными парами для заданного набора гиперпараметров θ.[10]Таким образом, маргинальная вероятность журнала составляет:

и максимизируя эту предельную вероятность θ обеспечивает полную спецификацию гауссовского процесса ж. Здесь можно вкратце отметить, что первый член соответствует штрафному члену за неспособность модели соответствовать наблюдаемым значениям, а второй член - штрафному члену, который увеличивается пропорционально сложности модели. Указав θ делать прогнозы о ненаблюдаемых ценностях в координатах Икс* в таком случае нужно всего лишь взять образцы из прогнозного распределения. где апостериорная средняя оценка А определяется как

и оценка апостериорной дисперсии B определяется как:

куда ковариация между новой координатой оценки Икс* и все другие наблюдаемые координаты Икс для данного вектора гиперпараметров θ, и определены как раньше и дисперсия в точке Икс* как продиктовано θ. Важно отметить, что практически апостериорная средняя оценка («точечная оценка») - это просто линейная комбинация наблюдений ; аналогичным образом дисперсия фактически не зависит от наблюдений . Известным узким местом в прогнозировании гауссовского процесса является то, что вычислительная сложность вывода и оценки правдоподобия является кубической по количеству точек |Икс|, и поэтому может стать невозможным для больших наборов данных.[9] Работает над разреженными гауссовскими процессами, которые обычно основаны на идее построения представительный набор для данного процесса ж, попробуйте обойти эту проблему.[30][31]

Байесовские нейронные сети как гауссовские процессы

Байесовские нейронные сети - это особый тип Байесовская сеть что является результатом лечения глубокое обучение и искусственная нейронная сеть моделирует вероятностно, и присваивая предварительное распространение к их параметры. Вычисления в искусственных нейронных сетях обычно организованы в последовательные слои искусственные нейроны. Количество нейронов в слое называется шириной слоя. По мере увеличения ширины слоя многие байесовские нейронные сети сводятся к гауссовскому процессу с закрытая форма композиционное ядро. Этот гауссовский процесс называется гауссовским процессом нейронной сети (NNGP). Он позволяет более эффективно оценивать прогнозы байесовских нейронных сетей и предоставляет аналитический инструмент для понимания глубокое обучение модели.

Вычислительные проблемы

В практических приложениях модели гауссовских процессов часто оцениваются на сетке, приводящей к многомерным нормальным распределениям. Использование этих моделей для прогнозирования или оценки параметров с использованием максимального правдоподобия требует оценки многомерной гауссовой плотности, которая включает в себя вычисление детерминанта и обратного значения ковариационной матрицы. Обе эти операции имеют кубическую вычислительную сложность, а это означает, что даже для сеток небольшого размера обе операции могут иметь непомерно высокие вычислительные затраты. Этот недостаток привел к развитию множества методы аппроксимации.

Смотрите также

- Линейная статистика Байеса

- Байесовская интерпретация регуляризации

- Кригинг

- Гауссово свободное поле

- Процесс Гаусса – Маркова

- Кригинг с усилением градиента (GEK)

- Студенческий t-процесс

Рекомендации

- ^ «Инновация Platypus: простое введение в гауссовские процессы (отличный инструмент для моделирования данных)». 2016-05-10.

- ^ Чен, Зексун; Fan, Jun; Ван, Куо (2020). «Замечания о многомерном гауссовском процессе». arXiv:2010.09830 [math.ST].

- ^ а б Чен, Зексун; Ван, Бо; Горбань, Александр Н. (2019). «Многомерная гауссова регрессия и регрессия Стьюдента для прогнозирования с несколькими выходами». Нейронные вычисления и приложения. 32 (8): 3005–3028. arXiv:1703.04455. Дои:10.1007 / s00521-019-04687-8.

- ^ Маккей, Дэвид, Дж. (2003). Теория информации, логический вывод и алгоритмы обучения (PDF). Издательство Кембриджского университета. п. 540. ISBN 9780521642989.

Распределение вероятностей функции является гауссовским процессом, если для любого конечного набора точек , плотность гауссовский

- ^ Дадли, Р. (1989). Реальный анализ и вероятность. Уодсворт и Брукс / Коул.

- ^ а б Амос Лапидот (8 февраля 2017 г.). Фонд цифровых коммуникаций. Издательство Кембриджского университета. ISBN 978-1-107-17732-1.

- ^ Kac, M .; Зигерт, A.J.F (1947). «Явное представление стационарного гауссовского процесса». Анналы математической статистики. 18 (3): 438–442. Дои:10.1214 / aoms / 1177730391.

- ^ а б Бишоп, К. (2006). Распознавание образов и машинное обучение. Springer. ISBN 978-0-387-31073-2.

- ^ а б c Барбер, Дэвид (2012). Байесовское мышление и машинное обучение. Издательство Кембриджского университета. ISBN 978-0-521-51814-7.

- ^ а б c d е ж Rasmussen, C.E .; Уильямс, C.K.I (2006). Гауссовские процессы для машинного обучения. MIT Press. ISBN 978-0-262-18253-9.

- ^ Гриммет, Джеффри; Дэвид Стирзакер (2001). Вероятность и случайные процессы. Oxford University Press. ISBN 978-0198572220.

- ^ Сигер, Маттиас (2004). «Гауссовские процессы для машинного обучения». Международный журнал нейронных систем. 14 (2): 69–104. CiteSeerX 10.1.1.71.1079. Дои:10.1142 / s0129065704001899. PMID 15112367.

- ^ Дадли, Р. М. (1975). «Гауссовский процесс и как к нему подойти» (PDF). Материалы Международного конгресса математиков.. 2. С. 143–146.

- ^ Дадли, Р. М. (1973). «Примерные функции гауссовского процесса». Анналы вероятности. 1 (1): 66–103. Дои:10.1007/978-1-4419-5821-1_13. ISBN 978-1-4419-5820-4.

- ^ Талагранд, Мишель (2014). Верхние и нижние оценки случайных процессов: современные методы и классические проблемы. Ergebnisse der Mathematik und ihrer Grenzgebiete. 3. Фольге / Серия современных математических обзоров. Спрингер, Гейдельберг. ISBN 978-3-642-54074-5.

- ^ Леду, Мишель (1994). «Изопериметрия и гауссовский анализ». Конспект лекций по математике. 1648. Спрингер, Берлин. С. 165–294. Дои:10.1007 / BFb0095676. ISBN 978-3-540-62055-6.

- ^ Адлер, Роберт Дж. (1990). «Введение в непрерывность, экстремумы и связанные темы для общих гауссовских процессов». Конспект лекций-Серия монографий. Институт математической статистики. 12: i – 155. JSTOR 4355563.

- ^ Берман, Симеон М. (1992). "Обзор: Адлер 1990 'Введение в преемственность ...'". Математические обзоры. МИСТЕР 1088478.

- ^ а б Дадли, Р. М. (1967). «Размеры компактных подмножеств гильбертова пространства и непрерывность гауссовских процессов». Журнал функционального анализа. 1 (3): 290–330. Дои:10.1016/0022-1236(67)90017-1.

- ^ а б Marcus, MB; Шепп, Лоуренс А. (1972). «Пример поведения гауссовских процессов». Труды шестого симпозиума Беркли по математической статистике и вероятности, т. II: теория вероятностей. Univ. Калифорния, Беркли. С. 423–441.

- ^ а б Маркус, Майкл Б.; Шепп, Лоуренс А. (1970). «Непрерывность гауссовских процессов». Труды Американского математического общества. 151 (2): 377–391. Дои:10.1090 / s0002-9947-1970-0264749-1. JSTOR 1995502.

- ^ Дрисколл, Майкл Ф. (1973). "Воспроизводящее ядро структура гильбертова пространства выборочных путей гауссовского процесса". Zeitschrift für Wahrscheinlichkeitstheorie und Verwandte Gebiete. 26 (4): 309–316. Дои:10.1007 / BF00534894. ISSN 0044-3719. S2CID 123348980.

- ^ Джидлинг, Карл; Вальстрём, Никлас; Уиллс, Адриан; Шен, Томас Б. (19 сентября 2017 г.). «Линейно ограниченные гауссовские процессы». arXiv:1703.00787 [stat.ML].

- ^ Документация для scikit-learn также есть аналогичные Примеры.

- ^ Liu, W .; Principe, J.C .; Хайкин, С. (2010). Адаптивная фильтрация ядра: всестороннее введение. Джон Вили. ISBN 978-0-470-44753-6. Архивировано из оригинал на 2016-03-04. Получено 2010-03-26.

- ^ Альварес, Маурисио А .; Росаско, Лоренцо; Лоуренс, Нил Д. (2012). «Ядра для векторнозначных функций: обзор» (PDF). Основы и тенденции в машинном обучении. 4 (3): 195–266. Дои:10.1561/2200000036. S2CID 456491.

- ^ Штейн, М. (1999). Интерполяция пространственных данных: теория кригинга. Springer.

- ^ Platanios, Emmanouil A .; Хатзис, Сотириос П. (2014). «Условная гетероскедастичность смеси гауссовских процессов». IEEE Transactions по анализу шаблонов и машинному анализу. 36 (5): 888–900. Дои:10.1109 / TPAMI.2013.183. PMID 26353224. S2CID 10424638.

- ^ Хатзис, Сотириос П. (2013). «Скрытая переменная гауссовская модель процесса с априорными процессами Питмана – Йорка для мультиклассовой классификации». Нейрокомпьютинг. 120: 482–489. Дои:10.1016 / j.neucom.2013.04.029.

- ^ Smola, A.J .; Шёллькопф, Б. (2000). «Аппроксимация разреженной жадной матрицы для машинного обучения». Материалы семнадцатой международной конференции по машинному обучению: 911–918. CiteSeerX 10.1.1.43.3153.

- ^ Csato, L .; Оппер, М. (2002). «Разреженные гауссовские процессы в реальном времени». Нейронные вычисления. 14 (3): 641–668. CiteSeerX 10.1.1.335.9713. Дои:10.1162/089976602317250933. PMID 11860686. S2CID 11375333.

внешняя ссылка

- Веб-сайт гауссовских процессов, включая текст гауссовских процессов для машинного обучения Расмуссена и Вильямса

- Мягкое введение в гауссовские процессы

- Обзор гауссовских случайных полей и корреляционных функций

- Эффективное обучение с подкреплением с использованием гауссовских процессов

Программного обеспечения

- GPML: комплексный набор инструментов Matlab для регрессии и классификации GP

- STK: небольшой (Matlab / Octave) набор инструментов для кригинга и моделирования GP

- Модуль кригинга в фреймворке UQLab (Matlab)

- Функция Matlab / Octave для стационарных гауссовских полей

- Yelp MOE - механизм оптимизации черного ящика с использованием процесса обучения по Гауссу

- ooDACE - Гибкий объектно-ориентированный набор инструментов Kriging Matlab.

- GPstuff - набор инструментов гауссовского процесса для Matlab и Octave

- GPy - фреймворк гауссовских процессов на Python

- GSTools - набор инструментов для геостатистики, включая регрессию гауссовского процесса, написанный на Python.

- Интерактивная демонстрация регрессии гауссовского процесса

- Базовая библиотека процессов Гаусса, написанная на C ++ 11

- scikit-learn - Библиотека машинного обучения для Python, которая включает регрессию и классификацию гауссовских процессов.

- [1] - Набор инструментов Kriging (KriKit) разработан в Институте био- и геонаук 1 (IBG-1) Forschungszentrum Jülich (FZJ)

![{ displaystyle operatorname {var} [X (t)] = operatorname {E} [| X (t) - operatorname {E} [X (t)] | ^ {2}] < infty quad { text {для всех}} t in T}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ae643c93ad0f56457881fa60e3bdae082fd5e73a)

![{ displaystyle [0, varepsilon]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/09b79b1e11f2a6c9b36a919ddbbf91204fe7a1df)

![{ displaystyle lim _ {n to infty} operatorname {tr} [K_ {n} R_ {n} ^ {- 1}] < infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c62de62758eb883e4255dab480943abdebdb00d9)

![{ Displaystyle Pr [е в { mathcal {H}} (R)] = 1}](https://wikimedia.org/api/rest_v1/media/math/render/svg/38ca6ca8c04250e643221318bc2b55241112519e)

![{ displaystyle lim _ {n to infty} operatorname {tr} [K_ {n} R_ {n} ^ {- 1}] = infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e133d11ae8a4dc2825314c86ec4c86df1aabb0fe)

![{ Displaystyle Pr [е в { mathcal {H}} (R)] = 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4cb02319fc30c845fd10102601b63961f296f931)

![{ displaystyle lim _ {n to infty} operatorname {tr} [R_ {n} R_ {n} ^ {- 1}] = lim _ {n to infty} operatorname {tr} [ I] = lim _ {n to infty} n = infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/70d34626fb759d05905dc20be06ded12144368c5)