WikiDer > Искусственный интеллект

| Часть серии по |

| Искусственный интеллект |

|---|

Технологии |

Глоссарий |

Искусственный интеллект (AI), является интеллект продемонстрировано машины, в отличие от естественный интеллект отображается людьми и животные. Ведущие учебники по ИИ определяют эту область как изучение "интеллектуальные агенты": любое устройство, которое воспринимает окружающую среду и предпринимает действия, которые увеличивают его шансы на успешное достижение поставленных целей.[3] В разговорной речи термин «искусственный интеллект» часто используется для описания машин (или компьютеров), которые имитируют «когнитивные» функции, которые люди связывают с человеческий разум, например, «обучение» и «решение проблем».[4]

По мере того, как машины становятся все более способными, задачи, которые, как считается, требуют «интеллекта», часто исключаются из определения ИИ. Эффект ИИ.[5] Колкость в теореме Теслера гласит: «ИИ - это то, что еще не было сделано».[6] Например, оптическое распознавание символов часто исключается из вещей, которые считаются ИИ,[7] став рутинной технологией.[8] Возможности современных машин, которые обычно классифицируются как ИИ, успешно включают понимание человеческой речи,[9] соревноваться на высшем уровне в стратегическая игра системы (такие как шахматы и Идти),[10] автономно работающие автомобили, интеллектуальная маршрутизация в сети доставки контента, и военные симуляторы.[11]

Искусственный интеллект был основан как академическая дисциплина в 1955 году и за прошедшие годы испытал несколько волн оптимизма.[12][13] за которым последовало разочарование и потеря финансирования (известная как "AI зима"),[14][15] за ними последовали новые подходы, успех и возобновление финансирования.[13][16] После AlphaGo успешно победил профессионала Идти В 2015 году искусственный интеллект снова привлек всеобщее внимание.[17] На протяжении большей части своей истории исследования ИИ были разделены на подполя, которые часто не взаимодействуют друг с другом.[18] Эти подполя основаны на технических соображениях, таких как конкретные цели (например, "робототехника" или же "машинное обучение"),[19] использование определенных инструментов ("логика" или же искусственные нейронные сети) или глубокие философские разногласия.[22][23][24] Подполи также основывались на социальных факторах (конкретных учреждениях или работе конкретных исследователей).[18]

Традиционные проблемы (или цели) исследований ИИ включают: рассуждение, представление знаний, планирование, учусь, обработка естественного языка, восприятие и возможность перемещать объекты и манипулировать ими.[19] Общий интеллект входит в число долгосрочных целей отрасли.[25] Подходы включают Статистические методы, вычислительный интеллект, и традиционный символический ИИ. В ИИ используется множество инструментов, включая версии поисковая и математическая оптимизация, искусственные нейронные сети и методы, основанные на статистике, вероятности и экономике. Область AI опирается на Информатика, информационная инженерия, математика, психология, лингвистика, философия, и многие другие поля.

Эта область была основана на предположении, что человеческий интеллект «можно так точно описать, что можно создать машину для его моделирования».[26] Это вызывает философские аргументы в пользу разума и этики создания искусственных существ, наделенных интеллектом, подобным человеческому. Эти вопросы были изучены миф, вымысел и философия поскольку древность.[31] Некоторые люди также считают ИИ опасность для человечества если он не ослабевает.[32][33] Другие считают, что ИИ, в отличие от предыдущих технологических революций, создаст риск массовой безработицы.[34]

В двадцать первом веке методы искусственного интеллекта пережили возрождение после одновременного развития мощность компьютера, большое количество данные, и теоретическое понимание; и методы искусственного интеллекта стали неотъемлемой частью технологическая промышленность, помогая решать множество сложных задач в области информатики, программная инженерия и исследование операций.[35][16]

История

Мыслящий искусственные существа появился как устройства для повествования в древности,[36] и были распространены в художественной литературе, как в Мэри Шеллис Франкенштейн или же Карел Чапекс R.U.R.[37] Эти персонажи и их судьбы подняли многие из тех же вопросов, которые сейчас обсуждаются в этика искусственного интеллекта.[31]

Изучение механики или "формальное" рассуждение началось с философы и математики в древности. Изучение математической логики непосредственно привело к Алан Тьюрингс теория вычислений, который предполагает, что машина, перетасовывая такие простые символы, как «0» и «1», может имитировать любой мыслимый акт математического вывода. Это понимание того, что цифровые компьютеры могут моделировать любой процесс формального рассуждения, известно как Тезис Черча – Тьюринга.[38] Наряду с параллельными открытиями в нейробиология, теория информации и кибернетика, это побудило исследователей рассмотреть возможность построения электронного мозга. Тьюринг предложил изменить вопрос с того, является ли машина разумной, на «может ли машина проявлять разумное поведение или нет».[39] Первой работой, которая сейчас широко известна как ИИ, была McCullouch и Питтс'1943 г. официальный дизайн для Полный по Тьюрингу «искусственные нейроны».[40]

Область исследований ИИ зародилась в мастерская в Дартмутский колледж в 1956 г.,[41] где термин «искусственный интеллект» был придуман Джон Маккарти отличить сферу от кибернетики и избежать влияния кибернетиков Норберт Винер.[42] Участники Аллен Ньюэлл (CMU), Герберт Саймон (CMU), Джон Маккарти (Массачусетский технологический институт), Марвин Мински (MIT) и Артур Сэмюэл (IBM) стали основоположниками и лидерами исследований ИИ.[43] Они и их ученики создали программы, которые пресса назвала «поразительными»:[44] компьютеры учились шашки стратегии (ок. 1954)[45] (и к 1959 году, как сообщается, играли лучше, чем средний человек),[46] решение словесных задач по алгебре, доказательство логические теоремы (Теоретик логики, первый запуск c. 1956) и говорящий по-английски.[47] К середине 1960-х исследования в США в значительной степени финансировались Министерство обороны[48] и лаборатории были созданы по всему миру.[49] Основатели AI с оптимизмом смотрели в будущее: Герберт Саймон предсказал, что «в течение двадцати лет машины будут способны выполнять любую работу, которую может выполнять человек». Марвин Мински согласился, написав: «в течение одного поколения ... проблема создания« искусственного интеллекта »будет существенно решена».[12]

Они не осознали сложности некоторых оставшихся задач. Прогресс замедлился, и в 1974 г. в ответ на критику Сэр Джеймс Лайтхилл[50] и продолжающееся давление со стороны Конгресса США с целью финансирования более продуктивных проектов, правительства США и Великобритании прекратили исследовательские исследования в области ИИ. Следующие несколько лет спустя будут названы "AI зима",[14] период, когда получение финансирования для проектов ИИ было трудным.

В начале 1980-х годов исследования ИИ были возрождены коммерческим успехом экспертные системы,[51] форма программы искусственного интеллекта, имитирующая знания и аналитические навыки экспертов-людей. К 1985 году рынок ИИ превысил миллиард долларов. В то же время в Японии компьютер пятого поколения проект вдохновил правительства США и Великобритании восстановить финансирование академическое исследование.[13] Однако, начиная с распада Лисп-машина На рынке в 1987 году ИИ снова приобрел дурную славу, и начался второй, более продолжительный перерыв.[15]

Развитие металл – оксид – полупроводник (MOS) очень крупномасштабная интеграция (СБИС), в виде дополнительный MOS (CMOS) транзистор технологии, позволили разработать практические искусственная нейронная сеть (ИНС) в 1980-е годы. Знаковой публикацией в этой области стала книга 1989 г. Аналоговая реализация нейронных систем на СБИС Карвер А. Мид и Мохаммед Исмаил.[52]

В конце 1990-х и начале 21 века ИИ начали использовать в логистике, сбор данных, медицинский диагноз и другие области.[35] Успех был связан с увеличением вычислительной мощности (см. Закон Мура и количество транзисторов), больший упор на решение конкретных проблем, новые связи между ИИ и другими областями (такими как статистика, экономика и математика), а также приверженность исследователей математическим методам и научным стандартам.[53] Темно-синий стала первой компьютерной шахматной системой, победившей действующего чемпиона мира по шахматам, Гарри Каспаров11 мая 1997 г.[54]

В 2011 г. Опасность! викторина выставочный матч IBMс система ответов на вопросы, Watson, победил двух величайших Опасность! чемпионы Брэд Раттер и Кен Дженнингс, со значительным отрывом.[55] Более быстрые компьютеры, алгоритмические улучшения и доступ к большие объемы данных позволил продвинуться в машинное обучение и восприятие; жадный до данных глубокое обучение методы начали доминировать в тестах точности около 2012 года.[56] В Kinect, который обеспечивает трехмерный интерфейс движения тела для Xbox 360 и Xbox One, использует алгоритмы, основанные на длительных исследованиях ИИ.[57] как и умные личные помощники в смартфоны.[58] В марте 2016 г. AlphaGo выиграл 4 из 5 игр Идти в матче с чемпионом го Ли Седол, став первым компьютерная игровая система победить профессионального игрока в го без физические недостатки.[10][59] В 2017 году Будущее Go Summit, AlphaGo Выиграл матч из трех игр с Ке Цзе,[60] который в то время непрерывно занимал первое место в мире в течение двух лет.[61][62] Это ознаменовало собой завершение важной вехи в развитии искусственного интеллекта, поскольку Го - относительно сложная игра, более сложная, чем шахматы.

В соответствии с Bloomberg's Джек Кларк, 2015 год стал знаковым для искусственного интеллекта, поскольку в ряде программных проектов используется ИИ. Google увеличилась с «спорадического использования» в 2012 году до более чем 2700 проектов. Кларк также представляет фактические данные, указывающие на улучшения ИИ с 2012 года, поддерживаемые более низким уровнем ошибок в задачах обработки изображений.[63] Он объясняет это увеличением доступных нейронные сетииз-за роста инфраструктуры облачных вычислений и увеличения числа исследовательских инструментов и наборов данных.[16] Другие приведенные примеры включают разработку Microsoft системы Skype, которая может автоматически переводить с одного языка на другой, и системы Facebook, которая может описывать изображения слепым людям.[63] В опросе 2017 года каждая пятая компания сообщила, что «включила ИИ в некоторые предложения или процессы».[64][65] Примерно в 2016 г. Китай значительно ускорило государственное финансирование; Учитывая большой объем данных и быстро растущие результаты исследований, некоторые наблюдатели полагают, что он может стать «сверхдержавой ИИ».[66][67] Однако было признано, что сообщения об искусственном интеллекте имели тенденцию быть преувеличенными.[68][69][70]

Основы

Информатика определяет исследование ИИ как исследование "интеллектуальные агенты": любое устройство, которое воспринимает окружающую среду и предпринимает действия, которые увеличивают его шансы на успешное достижение своих целей.[3] Более подробное определение характеризует ИИ как «способность системы правильно интерпретировать внешние данные, учиться на них и использовать полученные знания для достижения конкретных целей и задач посредством гибкой адаптации».[71]

Типичный ИИ анализирует окружающую среду и предпринимает действия, которые увеличивают его шансы на успех.[3] ИИ предназначен функция полезности (или цель) может быть простым ("1, если ИИ выиграет игру Идти, 0 в противном случае ") или сложным (" Выполняйте действия, математически похожие на те, которые были успешными в прошлом "). Цели могут быть явно определены или вызваны. Если ИИ запрограммирован на"обучение с подкреплением", цели могут быть косвенно вызваны поощрением одних типов поведения или наказанием других.[а] С другой стороны, эволюционная система может побуждать к достижению целей, используя "фитнес-функция«мутировать и предпочтительно копировать высоко оцененные системы ИИ, подобно тому, как животные эволюционировали, чтобы врожденно стремиться к определенным целям, таким как поиск пищи.[72] Некоторые системы искусственного интеллекта, такие как система ближайшего соседа, вместо рассуждений по аналогии, как правило, не ставят цели, за исключением той степени, в которой цели неявны в их обучающих данных.[73] Такие системы все еще можно тестировать, если нецелевую систему оформить как систему, «целью» которой является успешное выполнение своей узкой задачи классификации.[74]

ИИ часто вращается вокруг использования алгоритмы. Алгоритм - это набор однозначных инструкций, которые может выполнять механический компьютер.[b] Сложный алгоритм часто строится поверх других, более простых алгоритмов. Простым примером алгоритма является следующий (оптимальный для первого игрока) рецепт игры на крестики-нолики:[75]

- Если у кого-то есть «угроза» (то есть две подряд), возьмите оставшийся квадрат. Иначе,

- если ход «разветвляется», создавая сразу две угрозы, сыграйте этот ход. Иначе,

- возьмите центральную площадь, если она свободна. Иначе,

- если ваш противник играл в углу, возьмите противоположный угол. Иначе,

- возьмите пустой угол, если он существует. Иначе,

- возьмите любой пустой квадрат.

Многие алгоритмы ИИ способны учиться на данных; они могут улучшить себя, изучая новые эвристика (стратегии, или «практические правила», которые хорошо работали в прошлом), или сами могут писать другие алгоритмы. Некоторые из «учащихся», описанных ниже, включая байесовские сети, деревья решений и ближайшего соседа, теоретически могут (учитывая бесконечные данные, время и память) научиться приближать любые функция, включая то, какая комбинация математических функций лучше всего описывает мир.[нужна цитата] Таким образом, эти учащиеся могут получить все возможные знания, рассматривая все возможные гипотезы и сопоставляя их с данными. На практике редко можно рассмотреть каждую возможность из-за феномена "комбинаторный взрыв", где время, необходимое для решения проблемы, растет в геометрической прогрессии. Большая часть исследований искусственного интеллекта связана с выяснением того, как идентифицировать и избегать рассмотрения широкого спектра возможностей, которые вряд ли будут полезны.[76][77] Например, при просмотре карты и поиске кратчайшего маршрута от Денвер к Нью-Йорк на Востоке в большинстве случаев можно не смотреть на любой путь через Сан-Франциско или другие районы далеко на западе; таким образом, ИИ, владеющий алгоритмом поиска пути, например А * может избежать комбинаторного взрыва, который произошел бы, если бы все возможные пути были тщательно продуманы.[78]

Самым ранним (и наиболее простым для понимания) подходом к ИИ был символизм (такой как формальная логика): «Если у здорового взрослого человека жар, то он может грипп". Второй, более общий подход: Байесовский вывод: «Если у текущего пациента высокая температура, скорректируйте вероятность того, что у него грипп, таким-то образом». Третьим основным подходом, чрезвычайно популярным в рутинных бизнес-приложениях ИИ, являются аналогизаторы, такие как SVM и ближайший сосед: «После изучения записей известных прошлых пациентов, у которых температура, симптомы, возраст и другие факторы в основном совпадают с текущим пациентом, оказалось, что X% этих пациентов болеют гриппом». Четвертый подход сложнее интуитивно понять, но он основан на том, как работает механизм мозга: искусственная нейронная сеть подход использует искусственный "нейроны«который может учиться, сравнивая себя с желаемым результатом и изменяя силу связей между своими внутренними нейронами, чтобы« укрепить »связи, которые казались полезными. Эти четыре основных подхода могут пересекаться друг с другом и с эволюционными системами; например, нейронные сети могут научиться делать выводы, обобщать и проводить аналогии. Некоторые системы неявно или явно используют несколько из этих подходов, наряду со многими другими алгоритмами ИИ и не-ИИ; лучший подход часто отличается в зависимости от проблемы.[79][80]

Алгоритмы обучения работают на том основании, что стратегии, алгоритмы и выводы, которые хорошо работали в прошлом, вероятно, продолжат хорошо работать и в будущем. Эти выводы могут быть очевидными, например, «поскольку солнце вставало каждое утро в течение последних 10 000 дней, оно, вероятно, взойдет и завтра утром». Они могут иметь нюансы, например "X% от семьи имеют географически отдельные виды с цветовыми вариантами, поэтому существует вероятность Y%, что неоткрытые черные лебеди существуют ". Учащиеся тоже работают на основе"бритва Оккама": Самая простая теория, объясняющая данные, наиболее вероятна. Следовательно, согласно принципу бритвы Оккама, ученик должен быть спроектирован таким образом, чтобы он предпочитал более простые теории сложным теориям, за исключением случаев, когда сложная теория доказана значительно лучше.

Выбор плохой, слишком сложной теории, приспособленной ко всем прошлым обучающим данным, известен как переоснащение. Многие системы пытаются уменьшить переобучение, вознаграждая теорию в соответствии с тем, насколько хорошо она соответствует данным, но наказывая теорию в соответствии с ее сложностью.[81] Помимо классической переобучения, учащиеся также могут разочаровать, «усвоив неправильный урок». Игрушечный пример: классификатор изображений, обученный только изображениям коричневых лошадей и черных кошек, может сделать вывод, что все коричневые пятна, скорее всего, принадлежат лошадям.[82] Пример из реальной жизни состоит в том, что, в отличие от людей, современные классификаторы изображений часто не выносят суждений в первую очередь на основании пространственных отношений между компонентами изображения, и они изучают отношения между пикселями, которые люди не замечают, но которые все же коррелируют с изображениями определенные типы реальных объектов. Изменение этих шаблонов на легитимном изображении может привести к появлению «состязательных» изображений, которые система неправильно классифицирует.[c][83][84]

По сравнению с людьми существующий ИИ лишен некоторых черт человеческого "здравый смысл"; в первую очередь, у людей есть мощные механизмы рассуждений о"наивная физика"такие как пространство, время и физические взаимодействия. Это позволяет даже маленьким детям легко делать выводы вроде" Если я скатываю эту ручку со стола, она упадет на пол ". У людей также есть мощный механизм"народная психология«что помогает им интерпретировать предложения на естественном языке, такие как« члены городского совета отказали демонстрантам в разрешении, потому что они выступали за насилие »(общий ИИ с трудом определяет, являются ли те, кто якобы пропагандирует насилие, члены совета или демонстранты[87][88][89]). Это отсутствие «общих знаний» означает, что ИИ часто совершает ошибки, отличные от ошибок людей, и это может показаться непонятным. Например, существующие беспилотные автомобили не могут рассуждать о местонахождении или намерениях пешеходов точно так же, как люди, и вместо этого должны использовать нечеловеческие способы рассуждений, чтобы избежать несчастных случаев.[90][91][92]

Вызовы

Когнитивные возможности современных архитектур очень ограничены, они используют только упрощенную версию того, на что действительно способен интеллект. Например, человеческий разум придумал невероятные способы рассуждений и логические объяснения различных событий в жизни. То, что в противном случае было бы простым, может быть сложно решить с помощью вычислений, а не с помощью человеческого разума. Это порождает два класса моделей: структуралистские и функционалистские. Структурные модели стремятся имитировать основные интеллектуальные операции разума, такие как рассуждения и логика. Функциональная модель относится к коррелирующим данным с их вычисленным аналогом.[93]

Общая цель исследования искусственного интеллекта - создать технологию, которая позволяет компьютерам и машинам функционировать разумно. Общая проблема моделирования (или создания) интеллекта была разбита на подзадачи. Они состоят из определенных черт или способностей, которые исследователи ожидают от интеллектуальной системы. Наибольшее внимание привлекли характеристики, описанные ниже.[19]

Рассуждение, решение проблем

Ранние исследователи разработали алгоритмы, имитирующие пошаговые рассуждения, которые люди используют при решении головоломок или логических выводах.[94] К концу 1980-х и 1990-х годах в исследованиях искусственного интеллекта были разработаны методы борьбы с неуверенный или неполная информация, использующая концепции из вероятность и экономика.[95]

Этих алгоритмов оказалось недостаточно для решения больших задач рассуждений, потому что они испытали «комбинаторный взрыв»: они становились экспоненциально медленнее по мере роста проблем.[76] Даже люди редко используют пошаговые выводы, которые могли смоделировать ранние исследования ИИ. Они решают большинство своих проблем, используя быстрые интуитивные суждения.[96]

Представление знаний

Представление знаний[97] и инженерия знаний[98] занимают центральное место в классических исследованиях ИИ. Некоторые «экспертные системы» пытаются собрать явные знания, которыми обладают эксперты в какой-то узкой области. Кроме того, некоторые проекты пытаются собрать «здравые знания», известные обычному человеку, в базу данных, содержащую обширные знания о мире. Среди вещей, которые может содержать исчерпывающая база здравого смысла, следующие: объекты, свойства, категории и отношения между объектами;[99] ситуации, события, состояния и время;[100] причины и следствия;[101] знание о знаниях (то, что мы знаем о том, что знают другие люди);[102] и многие другие, менее изученные области. Представление «того, что существует» - это онтология: набор объектов, отношений, концепций и свойств, формально описанных, чтобы программные агенты могли их интерпретировать. В семантика из них записаны как логика описания концепции, роли и индивиды и обычно реализуются как классы, свойства и индивиды в Язык веб-онтологий.[103] Самые общие онтологии называются верхние онтологии, которые пытаются заложить основу для всех остальных знаний[104] выступая в качестве посредников между онтологии предметной области которые охватывают конкретные знания о конкретной области знаний (сфере интересов или проблемной области). Такие формальные представления знаний могут использоваться при индексировании и поиске на основе содержимого,[105] интерпретация сцены,[106] поддержка принятия клинических решений,[107] открытие знаний (извлечение "интересных" и действенных выводов из больших баз данных),[108] и другие области.[109]

К наиболее сложным проблемам представления знаний относятся:

- Рассуждение по умолчанию и проблема квалификации

- Многие из вещей, которые люди знают, принимают форму «рабочих предположений». Например, если в разговоре появляется птица, люди обычно представляют себе животное размером с кулак, которое поет и летает. Но все это не относится ко всем птицам. Джон Маккарти выявил эту проблему в 1969 г.[110] в качестве квалификационной проблемы: для любого правила здравого смысла, которое исследователи ИИ хотят представить, как правило, существует огромное количество исключений. Практически нет ничего просто истинного или ложного в том смысле, который требует абстрактная логика. В рамках исследования искусственного интеллекта было изучено несколько решений этой проблемы.[111]

- Широта здравого смысла

- Число элементарных фактов, которые знает средний человек, очень велико. Исследовательские проекты, которые пытаются создать полную базу знаний здравый смысл (например., Цикл) требуют огромного количества трудоемких онтологическая инженерия- их нужно строить вручную, по одной сложной концепции за раз.[112]

- Подсимволическая форма некоторого здравого смысла

- Многое из того, что люди знают, не представлено в виде «фактов» или «утверждений», которые они могли бы выразить устно. Например, шахматный мастер будет избегать определенной шахматной позиции, потому что она «чувствует себя слишком открытой».[113] или же искусствовед может взглянуть на статую и понять, что это подделка.[114] Это бессознательные и субсимволические интуиции или тенденции человеческого мозга.[115] Такое знание информирует, поддерживает и обеспечивает контекст для символического, сознательного знания. Как и в случае со связанной проблемой субсимволических рассуждений, есть надежда, что расположенный AI, вычислительный интеллект, или же статистический ИИ предоставит способы представить эти знания.[115]

Планирование

Интеллектуальные агенты должны уметь ставить цели и достигать их.[116] Им нужен способ визуализировать будущее - представление о состоянии мира и уметь делать прогнозы о том, как их действия его изменят, - и уметь делать выбор, который максимизирует возможности полезность (или «ценность») доступных вариантов.[117]

В классических задачах планирования агент может предполагать, что это единственная система, действующая в мире, позволяющая ему быть уверенным в последствиях своих действий.[118] Однако, если агент - не единственный действующий субъект, тогда требуется, чтобы агент мог рассуждать в условиях неопределенности. Для этого требуется агент, который может не только оценивать свое окружение и делать прогнозы, но также оценивать свои прогнозы и адаптироваться на основе своей оценки.[119]

Многоагентное планирование использует сотрудничество и конкуренция многих агентов для достижения поставленной цели. Эмерджентное поведение как это используется эволюционные алгоритмы и рой интеллект.[120]

Учусь

Машинное обучение (ML), фундаментальная концепция исследований ИИ с момента создания этой области,[123] - это изучение компьютерных алгоритмов, которые автоматически улучшаются по мере накопления опыта.[124][125]

Обучение без учителя - это способность находить шаблоны в потоке ввода, не требуя от человека предварительной маркировки вводимых данных. Контролируемое обучение включает оба классификация и числовой регресс, который требует, чтобы человек сначала пометил входные данные. Классификация используется для определения того, к какой категории принадлежит что-либо, и происходит после того, как программа видит несколько примеров вещей из нескольких категорий. Регрессия - это попытка создать функцию, которая описывает взаимосвязь между входами и выходами и предсказывает, как выходы должны изменяться при изменении входов.[125] И классификаторы, и учащиеся регрессии могут рассматриваться как «аппроксиматоры функций», пытающиеся изучить неизвестную (возможно, неявную) функцию; например, классификатор спама можно рассматривать как обучающую функцию, которая преобразует текст электронного письма в одну из двух категорий: «спам» или «не спам». Теория вычислительного обучения может оценивать учащихся по вычислительная сложность, к сложность образца (сколько данных требуется) или другими понятиями оптимизация.[126] В обучение с подкреплением[127] агент награждается за хорошие отзывы и наказывается за плохие. Агент использует эту последовательность вознаграждений и наказаний, чтобы сформировать стратегию действий в своем проблемном пространстве.

Обработка естественного языка

Обработка естественного языка[128] (NLP) позволяет машинам читать и понимать человеческий язык. Достаточно мощная система обработки естественного языка позволила бы пользовательские интерфейсы на естественном языке и получение знаний непосредственно из источников, написанных людьми, таких как тексты новостной ленты. Некоторые простые приложения обработки естественного языка включают поиск информации, интеллектуальный анализ текста, ответ на вопрос[129] и машинный перевод.[130] Многие современные подходы используют частоту совпадения слов для построения синтаксических представлений текста. Стратегии поиска по ключевым словам популярны и масштабируемы, но неуместны; поисковый запрос по запросу «собака» может соответствовать только документам со словом «собака» и пропускать документ со словом «пудель». Стратегии "лексической близости" используют вхождение таких слов, как "случайность", оценить настроение документа. Современные статистические подходы НЛП могут сочетать все эти стратегии, а также другие, и часто обеспечивают приемлемую точность на уровне страницы или абзаца. Помимо семантического НЛП, конечная цель «повествовательного» НЛП - воплотить полное понимание здравого смысла.[131] К 2019 г. трансформаторархитектуры глубокого обучения могут генерировать связный текст.[132]

Восприятие

Машинное восприятие[133] это возможность использовать входные данные от датчиков (таких как камеры (видимый спектр или инфракрасный), микрофоны, беспроводные сигналы и активные лидар, сонар, радар и тактильные датчики) вывести аспекты мира. Приложения включают распознавание речи,[134] распознавание лиц, и распознавание объекта.[135] Компьютерное зрение это способность анализировать визуальный ввод. Такой ввод обычно неоднозначен; гигантский пешеход пятидесятиметрового роста, находящийся далеко, может воспроизводить те же пиксели, что и ближайший пешеход нормального размера, требуя, чтобы ИИ оценивал относительную вероятность и разумность различных интерпретаций, например, используя свою «объектную модель» для оценки этого пятидесятиметровых пешеходов не бывает.[136]

Движение и манипуляции

ИИ широко используется в робототехнике.[137] Передовой роботизированные руки и другие промышленные роботы, широко используемые на современных заводах, могут научиться на собственном опыте, как эффективно двигаться, несмотря на наличие трения и проскальзывания шестерен.[138] Современный мобильный робот в небольшой, статичной и видимой среде может легко определить свое местоположение и карта его окружение; однако динамические среды, такие как (в эндоскопия) внутренняя часть дышащего тела пациента представляет большую проблему. Планирование движения это процесс разбиения двигательной задачи на «примитивы», такие как отдельные совместные движения. Такое движение часто подразумевает податливое движение, процесс, при котором движение требует поддержания физического контакта с объектом.[139][140][141] Парадокс Моравца обобщает, что низкоуровневые сенсомоторные навыки, которые люди воспринимают как должное, нелегко запрограммировать в робота; парадокс назван в честь Ганс Моравец, который заявил в 1988 г., что «сравнительно легко заставить компьютеры показывать результаты на уровне взрослых в тестах интеллекта или игре в шашки, и трудно или невозможно дать им навыки годовалого ребенка, когда дело касается восприятия и мобильности».[142][143] Это объясняется тем, что, в отличие от шашек, физическая ловкость была прямой целью естественный отбор на миллионы лет.[144]

Социальный интеллект

Парадокс Моравека можно распространить на многие формы социального интеллекта.[146][147] Распределенная мультиагентная координация автономных транспортных средств остается сложной проблемой.[148] Аффективные вычисления представляет собой междисциплинарный зонтик, включающий системы, которые распознают, интерпретируют, обрабатывают или моделируют человеческие влияет.[149][150][151] Умеренные успехи, связанные с аффективными вычислениями, включают текстовые анализ настроений и, совсем недавно, мультимодальный анализ аффектов (см. мультимодальный анализ настроений), где ИИ классифицирует аффекты, отображаемые записанным на видео субъектом.[152]

В конечном итоге социальные навыки и понимание человеческих эмоций и теория игры будет ценным для социального агента. Способность предсказывать действия других, понимая их мотивы и эмоциональное состояние, позволит агенту принимать более правильные решения. Некоторые компьютерные системы имитируют человеческие эмоции и выражения, чтобы казаться более чувствительными к эмоциональной динамике человеческого взаимодействия или иным образом взаимодействие человека с компьютером.[153] Точно так же некоторые виртуальные помощники запрограммированы разговаривать или даже шутить; это имеет тенденцию давать наивным пользователям нереалистичное представление о том, насколько разумны существующие компьютерные агенты на самом деле.[154]

Общий интеллект

Исторически сложилось так, что такие проекты, как база знаний Cyc (1984–) и масштабная японская Компьютерные системы пятого поколения Инициатива (1982–1992) пыталась охватить широту человеческого познания. Эти ранние проекты не смогли избежать ограничений неколичественных моделей символической логики и, оглядываясь назад, сильно недооценили сложность междоменного ИИ. В настоящее время большинство современных исследователей ИИ вместо этого работают над управляемыми «узкими» приложениями ИИ (такими как медицинская диагностика или автомобильная навигация).[155] Многие исследователи предсказывают, что такая «узкая работа ИИ» в различных отдельных областях в конечном итоге будет включена в машину с общий искусственный интеллект (AGI), сочетающий в себе большинство узких навыков, упомянутых в этой статье, и в какой-то момент даже превосходящий человеческие способности в большинстве или во всех этих областях.[25][156] Многие достижения имеют общее междоменное значение. Одним из ярких примеров является то, что DeepMind в 2010-х разработал «обобщенный искусственный интеллект», который смог изучить множество разнообразных Atari игры самостоятельно, а позже разработал вариант системы, который успешно последовательное обучение.[157][158][159] Помимо передача обучения,[160] гипотетические прорывы в области AGI могут включать в себя разработку рефлексивных архитектур, которые могут участвовать в мета-рассуждениях, основанных на теории принятия решений, и выяснении того, как «выпить» всеобъемлющую базу знаний из всей неструктурированной Интернет.[9] Некоторые утверждают, что какой-то (пока не открытый) концептуально простой, но математически сложный «главный алгоритм» может привести к AGI.[161] Наконец, несколько «новых» подходов направлены на чрезвычайно точное моделирование человеческого интеллекта и считают, что антропоморфный такие функции, как искусственный мозг или смоделированный развитие ребенка может когда-нибудь достичь критической точки, когда появится общий интеллект.[162][163]

Многие проблемы, описанные в этой статье, могут также потребовать общего интеллекта, если машины должны решать проблемы так же хорошо, как люди. Например, даже конкретные простые задачи, такие как машинный перевод, требуют, чтобы машина читала и записывала на обоих языках (НЛП), следуйте аргументам автора (причина), знайте, о чем говорят (знание) и точно воспроизводят первоначальный замысел автора (социальный интеллект). Проблема вроде машинного перевода рассматривается "AI-полный", потому что все эти проблемы необходимо решать одновременно, чтобы достичь производительности машины на уровне человека.

Подходы

Нет установленной объединяющей теории или парадигма направляет исследования ИИ. Исследователи расходятся во мнениях по многим вопросам.[165] Вот некоторые из самых давних вопросов, которые остались без ответа: должен ли искусственный интеллект имитировать естественный интеллект путем изучения психология или же нейробиология? Или это человеческая биология так же неактуально для исследований ИИ, как биология птиц для авиационная техника?[22]Можно ли описать разумное поведение, используя простые элегантные принципы (например, логика или же оптимизация)? Или обязательно требует решения большого количества не связанных между собой проблем?[23]

Кибернетика и моделирование мозга

В 1940-х и 1950-х годах ряд исследователей исследовали связь между нейробиология, теория информации, и кибернетика. Некоторые из них построили машины, которые использовали электронные сети для демонстрации элементарного интеллекта, например В. Грей Уолтерс черепахи и Зверь Джона Хопкинса. Многие из этих исследователей собрались на собрания Телеологического общества в Университет Принстона и Ratio Club в Англии.[166] К 1960 году от этого подхода в значительной степени отказались, хотя некоторые его элементы были возрождены в 1980-х годах.

Символический

Когда в середине 1950-х годов стал возможен доступ к цифровым компьютерам, исследования искусственного интеллекта начали изучать возможность того, что человеческий интеллект можно свести к манипуляциям с символами. Исследование проводилось в трех учреждениях: Университет Карнеги Меллон, Стэнфорд, и Массачусетский технологический институт, и, как описано ниже, каждый разработал свой собственный стиль исследования. Джон Хогеланд назвал эти символические подходы к ИИ «старомодным добрым ИИ» илиГОФАИ".[167] В течение 1960-х годов символические подходы достигли большого успеха в имитации высокоуровневого «мышления» в небольших демонстрационных программах. Подходы, основанные на кибернетика или же искусственные нейронные сети были заброшены или отодвинуты на второй план.[168]Исследователи 1960-х и 1970-х годов были убеждены, что символические подходы в конечном итоге позволят создать машину с общий искусственный интеллект и считали это целью своего дела.

Когнитивное моделирование

Экономист Герберт Саймон и Аллен Ньюэлл изучили человеческие навыки решения проблем и попытались формализовать их, и их работа заложила основы области искусственного интеллекта, а также наука о мышлении, исследование операций и Наука управления. Их исследовательская группа использовала результаты психологический эксперименты по разработке программ, имитирующих методы, которые люди использовали для решения проблем. Эта традиция, основанная на Университет Карнеги Меллон в конечном итоге завершится развитием Парить архитектура середины 1980-х гг.[169][170]

На основе логики

В отличие от Саймона и Ньюэлла, Джон Маккарти считал, что машинам не нужно моделировать человеческое мышление, а вместо этого следует пытаться найти суть абстрактного мышления и решения проблем, независимо от того, используют ли люди одни и те же алгоритмы.[22] Его лаборатория в Стэнфорд (ПЛЫТЬ) сосредоточены на использовании формальных логика для решения самых разных задач, в том числе представление знаний, планирование и учусь.[171] Логика также была в центре внимания работы на Эдинбургский университет и в других странах Европы, что привело к развитию языка программирования Пролог и наука о логическое программирование.[172]

Антилогичный или неряшливый

Исследователи из Массачусетский технологический институт (Такие как Марвин Мински и Сеймур Паперт)[173] обнаружил, что решение сложных проблем в зрение и обработка естественного языка требовали специальных решений - они утверждали, что нет простого и общего принципа (например, логика) охватит все аспекты разумного поведения. Роджер Шэнк описали свои «антилогические» подходы как «неряшливый"(в отличие от"аккуратный"парадигмы в CMU и Стэнфорд).[23] Базы здравого смысла (Такие как Дуг Ленатс Цикл) являются примером «неряшливого» ИИ, поскольку они должны создаваться вручную, по одной сложной концепции за раз.[174]

Основанный на знаниях

Когда примерно в 1970 году стали доступны компьютеры с большой памятью, исследователи всех трех традиций начали создавать знание в приложения AI.[175] Эта «революция знаний» привела к разработке и внедрению экспертные системы (представлен Эдвард Фейгенбаум), первой действительно успешной формы программного обеспечения AI.[51] Ключевым компонентом системной архитектуры для всех экспертных систем является база знаний, в которой хранятся факты и правила, иллюстрирующие ИИ.[176] Революция в области знаний также была вызвана осознанием того, что многие простые приложения ИИ потребуют огромных объемов знаний.

Субсимволический

К 1980-м годам казалось, что прогресс в области символического ИИ остановился, и многие считали, что символические системы никогда не смогут имитировать все процессы человеческого познания, особенно восприятие, робототехника, учусь и распознавание образов. Ряд исследователей начали изучать «субсимвольные» подходы к конкретным проблемам ИИ.[24] Субсимволические методы позволяют приблизиться к интеллекту без конкретных представлений знаний.

Воплощенный интеллект

Это включает в себя воплощенный, расположенный, основанный на поведении, и новый AI. Исследователи из смежной области робототехники, такие как Родни Брукс, отказался от символического ИИ и сосредоточился на основных инженерных проблемах, которые позволили бы роботам двигаться и выживать.[177] Их работа возродила несимволическую точку зрения раннего кибернетика исследователи 1950-х годов и возобновили использование теория управления в AI. Это совпало с развитием тезис воплощенного разума в соответствующей области наука о мышлении: идея о том, что аспекты тела (такие как движение, восприятие и визуализация) необходимы для более высокого интеллекта.

В развивающая робототехникаразработаны подходы к развивающему обучению, позволяющие роботам накапливать репертуар новых навыков посредством автономного самоисследования, социального взаимодействия с учителями-людьми и использования механизмов руководства (активное обучение, созревание, моторная синергия и т. д.).[178][179][180][181]

Вычислительный интеллект и мягкие вычисления

Интерес к нейронные сети и "коннекционизм"был возрожден Дэвид Румелхарт и другие в середине 1980-х гг.[182] Искусственные нейронные сети являются примером мягкие вычисления- это решения проблем, которые не могут быть решены с полной логической уверенностью и для которых зачастую достаточно приблизительного решения. Другой мягкие вычисления подходы к ИИ включают нечеткие системы, Теория серых систем, эволюционные вычисления и множество статистических инструментов. Применение мягких вычислений в искусственном интеллекте коллективно изучается развивающейся дисциплиной: вычислительный интеллект.[183]

Статистический

Много традиционных ГОФАИ увяз в для этого случая патчи к символьное вычисление которые работали на их собственных игрушечных моделях, но не сумели обобщить их на реальные результаты. Однако примерно в 1990-х годах исследователи ИИ взяли на вооружение сложные математические инструменты, такие как скрытые марковские модели (ХМ), теория информации, и нормативный байесовский теория принятия решений для сравнения или унификации конкурирующих архитектур. Общий математический язык позволил обеспечить высокий уровень сотрудничества с более известными областями (например, математика, экономика или исследование операций).[d] По сравнению с GOFAI, новые методы «статистического обучения», такие как HMM и нейронные сети, стали более точными во многих практических областях, таких как сбор данных, без необходимости получения семантического понимания наборов данных. Рост успеха с реальными данными привел к усилению акцента на сравнении различных подходов с общими тестовыми данными, чтобы увидеть, какой из подходов работает лучше всего в более широком контексте, чем тот, который предоставляется идиосинкразическими игрушечными моделями; Исследования ИИ становились все более научный. В настоящее время результаты экспериментов часто строго поддаются измерению, а иногда (с трудом) воспроизводятся.[53][184] Различные методы статистического обучения имеют разные ограничения; например, базовая HMM не может моделировать бесконечное количество возможных комбинаций естественного языка.[185] Критики отмечают, что переход от GOFAI к статистическому обучению часто также является отходом от объяснимый ИИ. В исследованиях AGI некоторые ученые предостерегают от чрезмерной зависимости от статистического обучения и утверждают, что продолжение исследований GOFAI по-прежнему будет необходимо для достижения общего интеллекта.[186][187]

Интеграция подходов

- Парадигма интеллектуального агента

- An интеллектуальный агент это система, которая воспринимает окружающую среду и предпринимает действия, которые увеличивают ее шансы на успех. Простейшие интеллектуальные агенты - это программы, решающие определенные задачи. Более сложные агенты включают людей и организации людей (такие как фирмы). Парадигма позволяет исследователям напрямую сравнивать или даже комбинировать различные подходы к изолированным проблемам, задавая вопрос, какой агент лучше всего максимизирует данную «целевую функцию». Агент, решающий конкретную проблему, может использовать любой подход, который работает - некоторые агенты являются символическими и логическими, некоторые - субсимвольными. искусственные нейронные сети а другие могут использовать новые подходы. Парадигма также дает исследователям общий язык для общения с другими областями, такими как теория принятия решений и экономика, которые также используют концепции абстрактных агентов. Создание полного агента требует от исследователей решения реальных проблем интеграции; например, поскольку сенсорные системы дают неопределенную информацию об окружающей среде, системы планирования должны уметь работать в условиях неопределенности. Парадигма интеллектуальных агентов получила широкое распространение в 1990-х годах.[188]

- Агентские архитектуры и когнитивные архитектуры

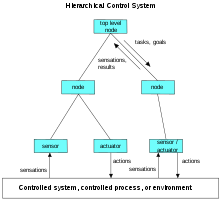

- Исследователи разработали системы для построения интеллектуальных систем из взаимодействующих интеллектуальные агенты в многоагентная система.[189] А иерархическая система управления обеспечивает мост между субсимвольным ИИ на его самом низком, реактивном уровнях и традиционным символическим ИИ на его высших уровнях, где смягченные временные ограничения позволяют планировать и моделировать мир.[190] Некоторые когнитивные архитектуры созданы специально для решения узкой проблемы; другие, такие как Парить, предназначены для имитации человеческого познания и для понимания общего интеллекта. Современные расширения Soar гибридные интеллектуальные системы которые включают как символические, так и субсимвольные компоненты.[191][192]

Инструменты

Приложения

AI актуален для любой интеллектуальной задачи.[193] Современные методы искусственного интеллекта широко распространены[194] и их слишком много, чтобы перечислять их здесь. Часто, когда техника становится популярной, ее больше не считают искусственным интеллектом; это явление описывается как Эффект ИИ.[195]

Яркие примеры ИИ включают автономные транспортные средства (такие как дроны и беспилотные автомобили), медицинский диагноз, создание произведений искусства (например, стихов), доказательство математических теорем, игры (например, шахматы или го), поисковые системы (например, поиск Гугл), онлайн-помощники (например, Siri), распознавание изображений на фотографиях, фильтрация спама, прогнозирование задержки рейсов,[196] прогнозирование судебных решений,[197] таргетинг интернет-рекламы, [193][198][199] и хранилище энергии[200]

Поскольку сайты социальных сетей обгоняют телевидение в качестве источника новостей для молодежи, а новостные организации все больше полагаются на платформы социальных сетей для распространения информации,[201] Крупные издатели теперь используют технологию искусственного интеллекта (ИИ) для более эффективной публикации статей и увеличения объема трафика.[202]

AI также может производить Дипфейки, технология, изменяющая контент. ZDNet сообщает: «Это представляет собой нечто, чего на самом деле не было». Хотя 88% американцев считают, что Deepfakes может причинить больше вреда, чем пользы, только 47% из них считают, что они могут стать целью. Бум года выборов также открывает общественный дискурс угрозам видео фальсифицированных политических СМИ.[203]

Философия и этика

Этот раздел должен включать только краткий резюме другой статьи. (Август 2020 г.) |

Есть три философских вопроса, связанных с ИИ. [204]

- Ли общий искусственный интеллект возможно; может ли машина решить любую проблему, которую может решить человек с помощью интеллекта, или существуют жесткие ограничения на то, что машина может выполнить.

- Опасны ли интеллектуальные машины; как люди могут гарантировать этичное поведение машин и этичное использование.

- Может ли машина иметь разум, сознание и психические состояния в том же смысле, что и люди; если машина может быть разумный, и таким образом заслуживают определенных прав - и если машина может намеренно причинить вред.

Пределы общего искусственного интеллекта

- "Вежливое соглашение" Алана Тьюринга

- Не нужно решать, может ли машина «думать»; нужно только решить, может ли машина действовать так же разумно, как человек. Такой подход к философским проблемам, связанным с искусственным интеллектом, лежит в основе Тест Тьюринга.[205]

- В Предложение Дартмута

- «Каждый аспект обучения или любая другая особенность интеллекта может быть описана с такой точностью, что можно создать машину для его моделирования». Эта гипотеза была напечатана в предложении Дартмутской конференции 1956 года.[206]

- Гипотеза системы физических символов Ньюэлла и Саймона

- «Физическая система символов имеет необходимые и достаточные средства общего разумного действия». Ньюэлл и Саймон утверждают, что интеллект состоит из формальных операций с символами.[207] Хуберт Дрейфус утверждает, что, напротив, человеческий опыт зависит от бессознательного инстинкта, а не от сознательного манипулирования символами, и от «ощущения» ситуации, а не от явного символического знания. (Видеть Критика ИИ Дрейфусом.)[209][210]

- Гёделевские аргументы

- Гёдель сам,[211] Джон Лукас (в 1961 г.) и Роджер Пенроуз (в более подробном аргументе, начиная с 1989 г.) привел весьма технические аргументы в пользу того, что математики-люди могут постоянно видеть истинность своих собственных «утверждений Гёделя» и, следовательно, обладают вычислительными способностями, превосходящими возможности механических машин Тьюринга.[212] Однако некоторые люди не согласны с «гёделевскими аргументами».[213][214][215]

- В искусственный мозг аргумент

- Аргумент, утверждающий, что мозг может быть смоделирован машинами, и, поскольку мозг демонстрирует интеллект, эти моделируемые мозги также должны проявлять интеллект - следовательно, машины могут быть интеллектуальными. Ганс Моравец, Рэй Курцвейл и другие утверждали, что технологически возможно скопировать мозг непосредственно в оборудование и программное обеспечение, и что такая симуляция будет по существу идентична оригиналу.[162]

- В Эффект ИИ

- Гипотеза о том, что машины уже умный, но наблюдатели не смогли этого распознать. Например, когда Темно-синий бить Гарри Каспаров в шахматах машину можно охарактеризовать как проявление интеллекта. Однако сторонние наблюдатели обычно игнорируют поведение программы искусственного интеллекта, утверждая, что это не «настоящий» интеллект, а «настоящий» интеллект фактически определяется как то, что машины поведения не могут делать.

Этические машины

Машины с интеллектом могут использовать свой интеллект для предотвращения вреда и минимизации рисков; они могут иметь возможность использовать этическое мышление чтобы лучше выбирать свои действия в мире. Таким образом, существует потребность в разработке политики для разработки политики и регулирования искусственного интеллекта и робототехники.[216] Исследования в этой области включают машинная этика, искусственные моральные агенты, дружелюбный ИИ и обсуждение создания права человека framework также находится в стадии переговоров.[217]

Йозеф Вайценбаум в Компьютерная мощь и человеческий разум писали, что приложения ИИ по определению не могут успешно имитировать подлинное человеческое сочувствие и что использование технологии ИИ в таких областях, как обслуживание клиентов или же психотерапия[219] был глубоко заблуждается. Вайценбаума также беспокоило то, что исследователи ИИ (и некоторые философы) были готовы рассматривать человеческий разум как не что иное, как компьютерную программу (позиция, теперь известная как вычислитель). По мнению Вайценбаума, эти моменты предполагают, что исследования ИИ обесценивают человеческую жизнь.[220]

Искусственные моральные агенты

Венделл Валлах представил концепцию искусственные моральные агенты (AMA) в своей книге Моральные машины[221] Для Уоллаха AMA стали частью исследовательского ландшафта искусственного интеллекта, поскольку он руководствуется двумя его центральными вопросами, которые он определяет как «хочет ли человечество, чтобы компьютеры принимали моральные решения».[222] и "Могут ли боты действительно быть нравственными".[223] Для Уоллаха вопрос не сводится к проблеме ли машины могут демонстрировать эквивалент морального поведения, в отличие от ограничения какое общество может принять во внимание развитие AMA.[224]

Машинная этика

Сфера машинной этики связана с тем, чтобы дать машинам этические принципы или процедуру для открытия способа решения этических дилемм, с которыми они могут столкнуться, позволяя им действовать этически ответственным образом посредством принятия ими собственных этических решений.[225] Эта область была очерчена на Симпозиуме AAAI по машинной этике осенью 2005 года: «Прошлые исследования, касающиеся взаимосвязи между технологией и этикой, в основном были сосредоточены на ответственном и безответственном использовании технологий людьми, и некоторые люди интересовались тем, как люди должны относиться к машинам. Во всех случаях этическими рассуждениями занимались только люди. Пришло время добавить этическое измерение по крайней мере к некоторым машинам. Признание этических ответвлений поведения машин, а также недавних и потенциальных разработок в машиностроении автономия, требует этого. В отличие от взлома компьютеров, проблем с собственностью программного обеспечения, вопросов конфиденциальности и других тем, которые обычно приписываются компьютерной этике, машинная этика связана с поведением машин по отношению к людям-пользователям и другим машинам. Исследования в области машинной этики являются ключом к облегчению проблемы с автономными системами - можно было бы утверждать, что понятие автономных машин без такого измерение лежит в основе всех опасений по поводу машинного интеллекта. Кроме того, исследование машинной этики могло бы позволить обнаружить проблемы с текущими этическими теориями, продвигая наши взгляды на этику ».[226] Машинную этику иногда называют машинной моралью, вычислительной этикой или вычислительной моралью. Разнообразные перспективы этой зарождающейся области можно найти в сборнике «Машинная этика».[225] это проистекает из симпозиума AAAI Fall 2005 по машинной этике.[226]

Злобный и дружелюбный ИИ

Политолог Чарльз Т. Рубин считает, что ИИ нельзя ни спроектировать, ни гарантировать доброжелательность.[227] Он утверждает, что «любая достаточно развитая доброжелательность неотличима от недоброжелательности». Люди не должны предполагать, что машины или роботы будут относиться к нам благосклонно, потому что нет априори причина полагать, что они будут сочувствовать нашей системе морали, которая развивалась вместе с нашей особой биологией (которую ИИ не разделяют). Гиперинтеллектуальное программное обеспечение не обязательно решит поддерживать дальнейшее существование человечества, и его будет чрезвычайно трудно остановить. Эта тема также недавно стала обсуждаться в академических публикациях как реальный источник рисков для цивилизации, людей и планеты Земля.

Одно из предложений по борьбе с этим - обеспечить, чтобы первый в целом интеллектуальный ИИ былДружелюбный ИИ'и сможет управлять созданными впоследствии ИИ. Некоторые сомневаются, может ли такая проверка действительно оставаться в силе.

Ведущий исследователь ИИ Родни Брукс пишет: «Я думаю, что это ошибка - беспокоиться о том, что мы разрабатываем злонамеренный ИИ в любое время в ближайшие несколько сотен лет. Я думаю, что беспокойство проистекает из фундаментальной ошибки, заключающейся в том, что мы не проводим различия между очень реальными недавними достижениями в конкретном аспекте ИИ, а также масштабность и сложность создания разумного волевого интеллекта ».[228]

Смертельное автономное оружие вызывают озабоченность. В настоящее время более 50 стран исследуют роботов на поле боя, включая США, Китай, Россию и Великобританию. Многие люди, обеспокоенные рисками, связанными с сверхразумным ИИ, также хотят ограничить использование искусственных солдат и дронов.[229]

Машинное сознание, разум и разум

Если система ИИ копирует все ключевые аспекты человеческого интеллекта, будет ли эта система разумный- будет ли у него разум у которого есть сознательный опыт? Этот вопрос тесно связан с философской проблемой о природе человеческого сознания, обычно называемой трудная проблема сознания.

Сознание

Дэвид Чалмерс выявил две проблемы в понимании разума, которые он назвал «трудной» и «легкой» проблемами сознания.[230] Простая проблема - понять, как мозг обрабатывает сигналы, строит планы и контролирует поведение. Сложная проблема - объяснить, как это чувствует или почему это вообще должно ощущаться. Человек обработка информации легко объяснить, но человеческий субъективный опыт сложно объяснить.

Например, подумайте, что происходит, когда человеку показывают образец цвета и он идентифицирует его, говоря, что он красный. Простая задача требует только понимания механизма в мозгу, который позволяет человеку узнать, что образец цвета красный. Сложная проблема в том, что люди знают еще кое-что - они также знают как выглядит красный. (Учтите, что слепорожденный может знать, что что-то красное, не зная, как выглядит красный.)[e] Все знают, что существует субъективный опыт, потому что они делают это каждый день (например, все зрячие знают, как выглядит красный цвет). Сложная проблема состоит в том, чтобы объяснить, как мозг их создает, почему он существует и чем отличается от знаний и других аспектов мозга.

Вычислительность и функционализм

Вычислительность - это позиция в философия разума что человеческий разум или человеческий мозг (или и то, и другое) - это система обработки информации, а мышление - это форма вычислений.[231] Вычислительный подход утверждает, что отношения между разумом и телом аналогичны или идентичны отношениям между программным обеспечением и оборудованием и, таким образом, могут быть решением проблемы. проблема разума и тела. Эта философская позиция была вдохновлена работой исследователей искусственного интеллекта и когнитивистов в 1960-х годах и первоначально была предложена философами. Джерри Фодор и Хилари Патнэм.

Сильная гипотеза ИИ

Философская позиция, что Джон Сирл назвал "сильный ИИ" гласит: «Соответственно запрограммированный компьютер с правильными входами и выходами, таким образом, будет иметь разум точно так же, как человеческие существа».[233] Сирл возражает против этого утверждения своим Китайская комната аргумент, который просит нас посмотреть внутри компьютер и попытайтесь найти, где может быть "разум".[234]

Права роботов

Если можно создать машину, обладающую интеллектом, может ли она Чувствовать? Если он может чувствовать, имеет ли он те же права, что и человек? Эта проблема, теперь известная как "права роботов", в настоящее время рассматривается, например, Калифорнийской Институт будущего, хотя многие критики считают обсуждение преждевременным.[235] Некоторые критики трансгуманизм утверждать, что любые гипотетические права роботов лежат в спектре с права животных и права человека. [236] Эта тема подробно обсуждается в документальном фильме 2010 года. Подключи и молись,[237] и многие научно-фантастические СМИ, такие как Звездный путь Следующее поколение, с характером Данные командира, который боролся с тем, чтобы его разобрали для исследования и хотел «стать человеком», и роботизированные голограммы в «Вояджере».

Суперинтеллект

Есть ли пределы тому, насколько интеллектуальными машинами - или гибридами человека и машины - могут быть? Сверхразум, гиперинтеллект или сверхчеловеческий интеллект - это гипотетический агент, который будет обладать интеллектом, намного превосходящим интеллект самого яркого и одаренного человека. Суперинтеллект может также относиться к форме или степени интеллекта, которыми обладает такой агент.[156]

Технологическая особенность

Если исследования в Сильный ИИ производит достаточно интеллектуальное программное обеспечение, оно могло бы перепрограммироваться и улучшать себя. Улучшенное программное обеспечение могло бы даже лучше улучшаться, что привело бы к рекурсивное самосовершенствование.[238] Таким образом, новый интеллект может расти в геометрической прогрессии и значительно превзойти людей. Писатель-фантаст Вернор Виндж назвал этот сценарий "необычность".[239] Технологическая сингулярность - это когда ускорение прогресса в технологиях вызовет неконтролируемый эффект, при котором искусственный интеллект превзойдет человеческие интеллектуальные возможности и возможности контроля, радикально изменив или даже положив конец цивилизации. Поскольку возможности такого интеллекта могут быть невозможны для понимания, технологическая сингулярность - это явление, за пределами которого события непредсказуемы или даже непостижимы.[239][156]

Рэй Курцвейл использовал Закон Мура (который описывает неумолимое экспоненциальное улучшение цифровых технологий), чтобы вычислить, что настольные компьютеры к 2029 году будет иметь такую же вычислительную мощность, что и человеческий мозг, и предсказывает, что сингулярность произойдет в 2045 году.[239]

Трансгуманизм

Конструктор роботов Ганс Моравец, кибернетик Кевин Уорвик, и изобретатель Рэй Курцвейл предсказали, что люди и машины сольются в будущем в киборги которые более способны и мощны, чем любой другой.[240] Эта идея называется трансгуманизм, имеет корни в Олдос Хаксли и Роберт Эттингер.

Эдвард Фредкин утверждает, что «искусственный интеллект - следующий этап эволюции», идея, впервые предложенная Сэмюэл Батлер"s"Дарвин среди машин"еще в 1863 г., и Джордж Дайсон в одноименной книге 1998 года.[241]

Влияние

Долгосрочные экономические эффекты ИИ неизвестны. Опрос экономистов показал разногласия по поводу того, приведет ли растущее использование роботов и ИИ к значительному увеличению долгосрочного безработица, но в целом они согласны с тем, что это может быть чистая выгода, если продуктивность прибыль перераспределенный.[242] Исследование 2017 г. PricewaterhouseCoopers видит Китайская Народная Республика получение максимальной экономической выгоды от ИИ с 26,1% ВВП до 2030 г.[243] В официальном документе Европейского союза по искусственному интеллекту, опубликованном в феврале 2020 года, содержится призыв к использованию искусственного интеллекта для получения экономических выгод, включая «улучшение здравоохранения (например, более точную диагностику, более эффективную профилактику заболеваний), повышение эффективности сельского хозяйства, содействие смягчению последствий изменения климата и адаптации к нему, [и] повышение эффективности производственных систем за счет профилактического обслуживания », признавая при этом потенциальные риски.[194]

В отношения между автоматизацией и занятостью это сложно. Хотя автоматизация устраняет старые рабочие места, она также создает новые рабочие места за счет микроэкономических и макроэкономических эффектов.[244] В отличие от предыдущих волн автоматизации, многие рабочие места среднего класса могут быть устранены с помощью искусственного интеллекта; Экономист утверждает, что «беспокойство о том, что ИИ может сделать с рабочими местами то же самое, что паровая энергия сделала синих воротничков во время промышленной революции», «заслуживает серьезного отношения».[245] Субъективные оценки риска сильно различаются; например, Майкл Осборн и Карл Бенедикт Фрей По оценкам, 47% рабочих мест в США подвержены «высокому риску» потенциальной автоматизации, в то время как в отчете ОЭСР только 9% рабочих мест в США классифицируются как «высокорисковые».[246][247][248] Рабочие места с повышенным риском варьируются от помощников юриста до поваров быстрого питания, в то время как спрос на рабочие места, вероятно, вырастет для профессий, связанных с уходом, от личного здравоохранения до духовенства.[249] Автор Мартин Форд а другие идут еще дальше и утверждают, что многие работы рутинны, повторяемы и (для ИИ) предсказуемы; Форд предупреждает, что эти рабочие места могут быть автоматизированы в ближайшие пару десятилетий, и что многие из новых рабочих мест могут быть «недоступны для людей со средними возможностями» даже после переподготовки. Экономисты отмечают, что в прошлом технологии имели тенденцию увеличивать, а не сокращать общую занятость, но признают, что «мы на неизведанной территории» с ИИ.[34]

Потенциальные негативные эффекты ИИ и автоматизации были серьезной проблемой для Эндрю Янс Президентская кампания 2020 года В Соединенных Штатах.[250] Ираклий Беридзе, руководитель Центра искусственного интеллекта и робототехники при ЮНИКРИ, ООН, заявил, что «я думаю, что опасными приложениями для ИИ, с моей точки зрения, могут быть преступники или крупные террористические организации, использующие его для срыва крупных процессов или просто нанести чистый вред. [Террористы могут причинить вред] посредством цифровой войны, или это может быть комбинация робототехники, дронов, искусственного интеллекта и других вещей, которые могут быть действительно опасными. И, конечно же, другие риски исходят от таких вещей, как потеря рабочих мест. Если у нас будет огромное количество людей, которые потеряют работу и не найдут решения, это будет чрезвычайно опасно. Такие вещи, как летальные автономные системы оружия, должны управляться надлежащим образом - в противном случае существует огромная вероятность неправильного использования ».[251]

Риски узкого ИИ

Широкое распространение искусственного интеллекта могло иметь непреднамеренные последствия которые опасны или нежелательны. Ученые из Институт будущего жизни, среди прочего, описал некоторые краткосрочные исследовательские цели, чтобы увидеть, как ИИ влияет на экономику, законы и этику, связанные с ИИ, и как минимизировать риски безопасности ИИ. В долгосрочной перспективе ученые предложили продолжить оптимизацию функций, минимизируя возможные риски безопасности, связанные с новыми технологиями.[252]

Некоторые обеспокоены алгоритмический уклон, что программы ИИ могут непреднамеренно стать предвзятыми после обработки данных, которые демонстрируют предвзятость.[253] Алгоритмы уже нашли множество применений в правовых системах. Примером этого является КОМПАС, коммерческая программа, широко используемая Суды США оценить вероятность ответчик становясь рецидивист. ProPublica утверждает, что средний уровень риска рецидивов, установленный Компасом для черных подсудимых, значительно выше, чем средний уровень риска, установленный Компасом для белых подсудимых.[254]

Риски общего ИИ

Физик Стивен Хокинг, Microsoft основатель Билл Гейтс, профессор истории Юваль Ной Харари, и SpaceX основатель Илон Маск выразили озабоченность по поводу возможности того, что ИИ может развиться до такой степени, что люди не смогут его контролировать, при этом Хокинг предположил, что это может "заклинание конец человеческой расы".[255][256][257][258]

Развитие полного искусственного интеллекта может означать конец человечества. Как только люди разовьют искусственный интеллект, он будет развиваться сам по себе и со все возрастающей скоростью модернизировать себя. Люди, которые ограничены медленной биологической эволюцией, не могут конкурировать и будут вытеснены.

В его книге Суперинтеллект, философ Ник Бостром приводит аргумент, что искусственный интеллект будет представлять угрозу для человечества. Он утверждает, что достаточно умный ИИ, если он выбирает действия, основанные на достижении какой-либо цели, проявит сходящийся такое поведение, как получение ресурсов или защита от отключения. Если цели этого ИИ не полностью отражают цели человечества - одним из примеров является ИИ, которому приказано вычислять как можно больше цифр числа Пи - он может нанести вред человечеству, чтобы получить больше ресурсов или предотвратить отключение, в конечном итоге для лучшего достижения своей цели. . Бостром также подчеркивает сложность полной передачи человеческих ценностей передовым ИИ. Он использует гипотетический пример того, как ИИ ставит перед собой цель заставить людей улыбнуться, чтобы проиллюстрировать ошибочную попытку. Если бы ИИ в этом сценарии стал бы сверхразумным, утверждает Бостром, он мог бы прибегнуть к методам, которые большинство людей сочли бы ужасными, такими как введение «электродов в лицевые мышцы людей, чтобы вызывать постоянную сияющую ухмылку», потому что это было бы эффективным способ добиться своей цели - заставить людей улыбаться.[260] В его книге Совместимость с человеком, Исследователь ИИ Стюарт Дж. Рассел повторяет некоторые опасения Бострома, одновременно предлагая подход на разработку доказательно полезных машин, ориентированных на неуверенность и уважение к людям,[261]:173 возможно с участием обратное обучение с подкреплением.[261]:191–193

Обеспокоенность рисками, связанными с искусственным интеллектом, привела к некоторым громким пожертвованиям и инвестициям. Группа выдающихся технических титанов, в том числе Питер Тиль, Amazon Web Services и Маск выделили 1 миллиард долларов на OpenAI, некоммерческая компания, деятельность которой направлена на поддержку ответственного развития ИИ.[262] Мнение экспертов в области искусственного интеллекта неоднозначно: значительная часть людей обеспокоена и не обеспокоена рисками, связанными с появлением сверхспособностей ИИ.[263] Другие лидеры технологической индустрии считают, что искусственный интеллект в его нынешнем виде полезен и будет продолжать помогать людям. Генеральный директор Oracle Марк Херд заявил, что ИИ «фактически создаст больше рабочих мест, а не меньше», поскольку люди будут необходимы для управления системами ИИ.[264] Генеральный директор Facebook Марк Цукерберг считает, что ИИ «откроет для себя огромное количество положительных вещей», таких как лечение болезней и повышение безопасности автономных автомобилей.[265] В январе 2015 года Маск пожертвовал 10 миллионов долларов Институт будущего жизни для финансирования исследований по пониманию процесса принятия решений ИИ. Цель института - «вырастить мудрость, с помощью которой мы управляем» растущей мощью технологий. Маск также финансирует компании, разрабатывающие искусственный интеллект, такие как DeepMind и Заместитель чтобы «просто следить за тем, что происходит с искусственным интеллектом.[266] Я думаю, что здесь есть потенциально опасный исход ».[267][268]

Чтобы реализовать опасность неконтролируемого продвинутого ИИ, гипотетический ИИ должен пересилить или превзойти все человечество, что, по мнению меньшинства экспертов, является достаточно далекой возможностью в будущем, чтобы не стоило исследовать.[269][270] Другие контраргументы вращаются вокруг людей, которые обладают внутренней или конвергентной ценностью с точки зрения искусственного интеллекта.[271]

Регулирование

Регулирование искусственного интеллекта - это разработка политики и законов государственного сектора для продвижения и регулирования искусственный интеллект (AI);[272][273] поэтому это связано с более широким регулирование алгоритмов. Нормативно-правовая и политическая среда для ИИ - это новая проблема в юрисдикциях по всему миру, в том числе в Европейском Союзе.[274] Регулирование считается необходимым как для поощрения ИИ, так и для управления связанными с ним рисками.[275][276] Регулирование ИИ с помощью таких механизмов, как контрольные советы, также можно рассматривать как социальное средство для достижения Проблема управления AI.[277]

В художественной литературе

Способные к мысли искусственные существа появились как повествовательные устройства с древних времен,[36]и были постоянной темой в научная фантастика.

Обычный троп в этих работах началось с Мэри Шеллис Франкенштейн, где человеческое творение становится угрозой для своих хозяев. Сюда входят такие произведения, как Артура Кларка и Стэнли Кубрика 2001: Космическая одиссея (оба 1968 г.), с HAL 9000, смертоносный компьютер, отвечающий за Discovery One космический корабль, а также Терминатор (1984) и Матрица (1999). Напротив, редкие лояльные роботы, такие как Горт из День когда земля остановилась (1951) и епископ из Инопланетяне (1986) менее заметны в массовой культуре.[278]

Айзек Азимов представил Три закона робототехники во многих книгах и рассказах, в первую очередь в серии "Multivac" о сверхразумном компьютере с таким же названием. Законы Азимова часто упоминаются в непрофессиональных дискуссиях о машинной этике;[279] Хотя почти все исследователи искусственного интеллекта знакомы с законами Азимова через массовую культуру, они обычно считают эти законы бесполезными по многим причинам, одной из которых является их двусмысленность.[280]

Трансгуманизм (слияние людей и машин) исследуется в манга Призрак в доспехах и научно-фантастический сериал Дюна. В 80-е годы художник Хадзимэ Сораямасерия «Сексуальные роботы» была нарисована и опубликована в Японии, изображая реальную органическую человеческую форму с реалистичной мускулистой металлической кожей, а позже последовала книга «Гиноиды», которая использовалась или оказывала влияние на создателей кино, включая Джордж Лукас и другие креативы. Сораяма никогда не считал этих органических роботов реальной частью природы, но всегда считал неестественным продуктом человеческого разума, фантазией, существующей в уме, даже если она реализована в реальной форме.

В нескольких работах ИИ используется, чтобы заставить нас ответить на фундаментальный вопрос о том, что делает нас людьми, показывая нам искусственных существ, которые имеют способность чувствовать, и таким образом страдать. Это появляется в Карел Чапекс R.U.R., фильмы А.И. Искусственный интеллект и Ex Machina, а также роман Мечтают ли андроиды об электрических овцах?, к Филип К. Дик. Дик рассматривает идею о том, что наше понимание человеческой субъективности изменено технологиями, созданными с помощью искусственного интеллекта.[281]

Смотрите также

- А.И. Рост

- Проблема управления AI

- Гонка вооружений искусственного интеллекта

- Алгоритм выбора поведения

- Автоматизация бизнес-процессов

- Рассуждения на основе случая

- Гражданская наука

- Эмерджентный алгоритм

- Женский гендер в технологиях ИИ

- Глоссарий искусственного интеллекта

- Регулирование искусственного интеллекта

- Роботизированная автоматизация процессов

- Универсальный базовый доход

- Слабый ИИ

Пояснительные примечания

- ^ Сам акт раздачи вознаграждений можно формализовать или автоматизировать в виде "функция вознаграждения".

- ^ Терминология варьируется; видеть характеристики алгоритмов.

- ^ Состязательные уязвимости также могут привести к нелинейным системам или к нестандартным возмущениям. Некоторые системы настолько хрупкие, что изменение одного пикселя-противника предсказуемо приводит к ошибочной классификации.

- ^ Хотя такая «победа чистокровных» может быть следствием того, что поле становится более зрелым, AIMA заявляет, что на практике оба аккуратный и неряшливый подходы по-прежнему необходимы в исследованиях ИИ.

- ^ Это основано на Комната Марии, мысленный эксперимент, впервые предложенный Фрэнк Джексон в 1982 г.

Рекомендации

- ^ Пул, Макворт и Гебель, 1998 г., п. 1.

- ^ Рассел и Норвиг, 2003 г., п. 55.

- ^ а б c Определение ИИ как исследования интеллектуальные агенты:

- Пул, Макворт и Гебель (1998), который предоставляет версию, используемую в этой статье. Эти авторы используют термин «вычислительный интеллект» как синоним искусственного интеллекта.[1]

- Рассел и Норвиг (2003) (которые предпочитают термин «рациональный агент») и пишут: «В настоящее время в этой области широко применяется взгляд на весь агент».[2]

- Нильссон 1998

- Легг и Хаттер 2007

- ^ Рассел и Норвиг 2009, п. 2.

- ^ МакКордак 2004, п. 204

- ^ Малуф, Марк. «Искусственный интеллект: введение, стр. 37» (PDF). georgetown.edu. В архиве (PDF) с оригинала от 25 августа 2018 г.

- ^ «Как ИИ вносит революционные изменения в управление талантами и HR-технологии». Hackernoon. В архиве из оригинала 11 сентября 2019 г.. Получено 14 февраля 2020.

- ^ Шенк, Роджер С. (1991). «Где ИИ». Журнал AI. Vol. 12 нет. 4. п. 38.

- ^ а б Рассел и Норвиг 2009.

- ^ а б «AlphaGo - Google DeepMind». В архиве из оригинала 10 марта 2016 г.

- ^ Аллен, Грегори (апрель 2020 г.). «Объединенный центр искусственного интеллекта Министерства обороны - Понимание технологии искусственного интеллекта» (PDF). AI.mil - Официальный сайт Объединенного центра искусственного интеллекта Министерства обороны США. В архиве (PDF) из оригинала 21 апреля 2020 г.. Получено 25 апреля 2020.

- ^ а б Оптимизм раннего ИИ: * Герберт Саймон Цитировать: Саймон 1965, п. 96 цитируется в Crevier 1993, п. 109. * Марвин Мински Цитировать: Минский 1967, п. 2 цитируется в Crevier 1993, п. 109.

- ^ а б c Бум 1980-х: подъем экспертные системы, Пятое поколение, Алви, MCC, SCI: * МакКордак 2004, стр. 426–441 * Crevier 1993, стр. 161–162,197–203, 211, 240 * Рассел и Норвиг, 2003 г., п. 24 * NRC 1999, стр. 210–211 * Ньюквист 1994, стр. 235–248

- ^ а б Первый AI зима, Поправка Мэнсфилда, Отчет Лайтхилла * Crevier 1993, стр. 115–117 * Рассел и Норвиг, 2003 г., п. 22 * NRC 1999, стр. 212–213 * Хау 1994 * Ньюквист 1994, стр. 189–201

- ^ а б Второй AI зима: * МакКордак 2004, стр. 430–435 * Crevier 1993, стр. 209–210 * NRC 1999, стр. 214–216 * Ньюквист 1994, стр. 301–318

- ^ а б c ИИ становится чрезвычайно успешным в начале 21 века * Кларк 2015

- ^ Haenlein, Майкл; Каплан, Андреас (2019). «Краткая история искусственного интеллекта: прошлое, настоящее и будущее искусственного интеллекта». Обзор управления Калифорнии. 61 (4): 5–14. Дои:10.1177/0008125619864925. ISSN 0008-1256. S2CID 199866730.

- ^ а б Памела МакКордак (2004), п. 424) пишет о «грубом разрушении ИИ в подполях - зрение, естественный язык, теория принятия решений, генетические алгоритмы, робототехника ... и все это с собственным подподполем, - которым вряд ли есть что сказать друг другу».

- ^ а б c Этот список интеллектуальных качеств основан на темах, охватываемых основными учебниками по ИИ, в том числе: * Рассел и Норвиг, 2003 г. * Люгер и Стаблфилд 2004 * Пул, Макворт и Гебель, 1998 г. * Нильссон 1998

- ^ Колата 1982.

- ^ Производитель 2006.

- ^ а б c Биологический интеллект против интеллекта в целом:

- Рассел и Норвиг, 2003 г., стр. 2–3, которые проводят аналогию с авиационная техника.

- МакКордак 2004, стр. 100–101, который пишет, что существует «две основные ветви искусственного интеллекта: одна направлена на создание разумного поведения независимо от того, как это было реализовано, а другая - на моделирование интеллектуальных процессов, встречающихся в природе, особенно человеческих».

- Колата 1982, бумага в Наука, который описывает Маккарти безразличие к биологическим моделям. Колата цитирует Маккарти: «Это ИИ, поэтому нам все равно, реально ли он психологически».[20] Маккарти недавно подтвердил свою позицию на AI @ 50 конференция, на которой он сказал: «Искусственный интеллект по определению не является имитацией человеческого интеллекта».[21].

- ^ а б c Аккуратные против неряшливых: * МакКордак 2004, стр. 421–424, 486–489 * Crevier 1993, п. 168 * Нильссон 1983, стр. 10–11

- ^ а б Символический и субсимвольный ИИ: * Нильссон (1998, п. 7), который употребляет термин «субсимволический».

- ^ а б Общий интеллект (сильный ИИ) обсуждается в популярных введениях в ИИ: * Курцвейл 1999 и Курцвейл 2005

- ^ Увидеть Предложение Дартмута, под Философия, ниже.